| 编辑推荐: |

本文主要介绍了2025

年主流大语言模型(LLM)的架构演进,从 DeepSeek-V3、Llama 4

到 Kimi K2,涵盖 MLA、MoE、Sliding Window Attention

等关键技术。希望对你的学习有帮助。

本文来自于微信公众号硅基生命AIGC ,由火龙果软件Alice编辑,推荐。 |

|

本文原载于 Sebastian Raschka 发布的文章《The

Big LLM Architecture Comparison》。Raschka 是机器学习领域的资深专家,以深入浅出的技术分析闻名。文章旨在帮助大家全面了解

2025 年主流大语言模型(LLM)的架构演进,从 DeepSeek-V3、Llama 4 到 Kimi

K2,涵盖 MLA、MoE、Sliding Window Attention 等关键技术。

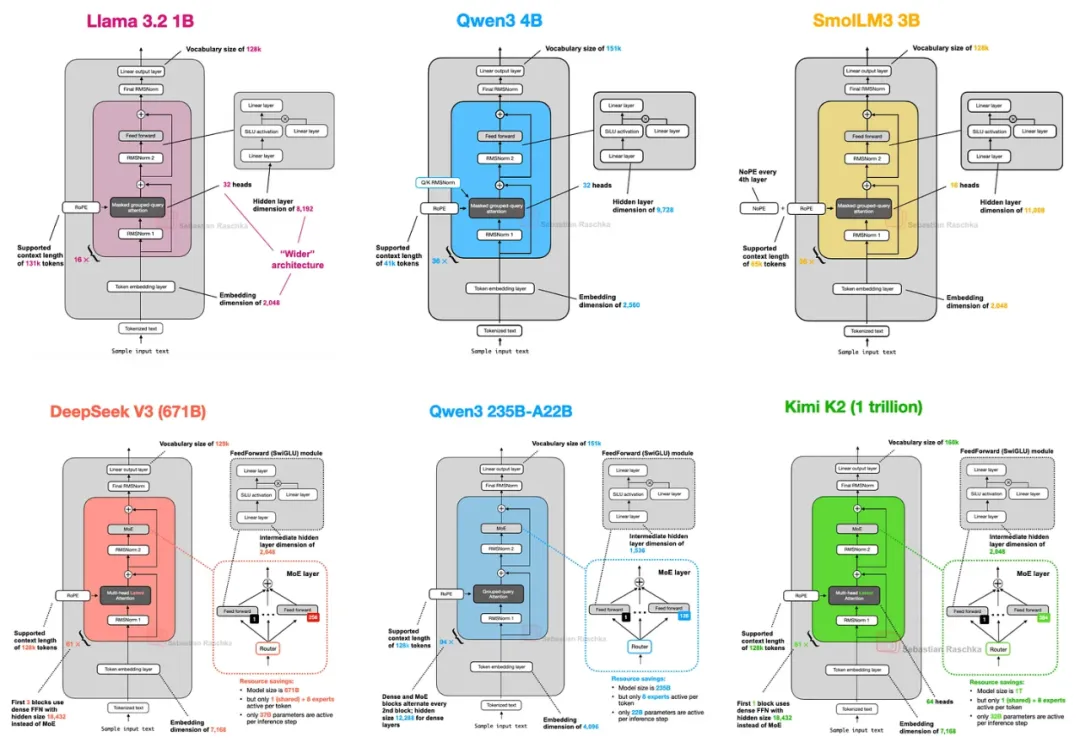

距离最初的 GPT 架构诞生已有七年。回顾 GPT-2(2019)再到 DeepSeek-V3 和

Llama 4(2024-2025),你可能会感到惊讶——这些模型在结构上仍然十分相似。

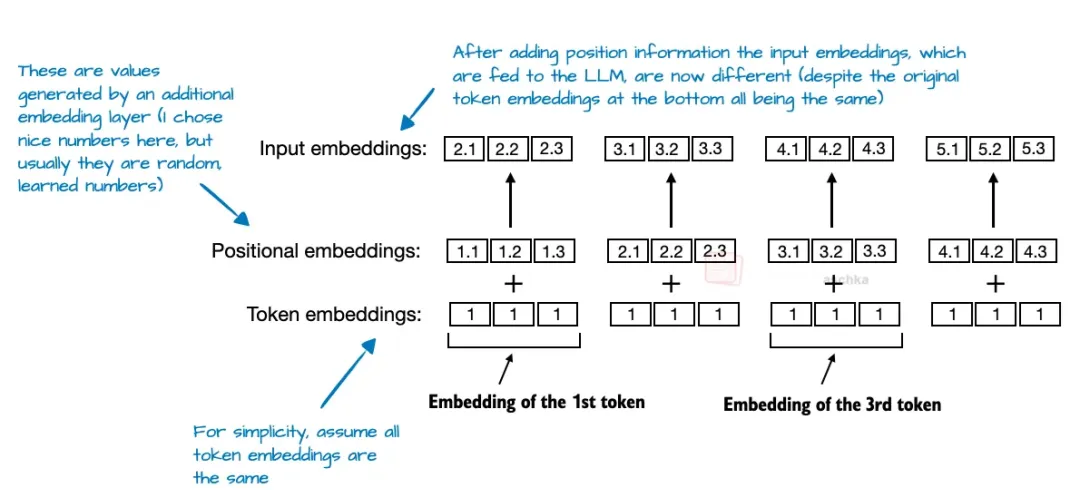

当然,位置嵌入已经从绝对位置嵌入演进为旋转位置嵌入(RoPE),多头注意力已被分组查询注意力取代,SwiGLU

激活函数也替换了之前常见的 GELU。但这些都只是“微调”。在这些小改进之下,我们是否真正见证了突破性的变化?还是只是在不断打磨相同的架构基础?

比较 LLM 并确定其性能优劣的关键因素极具挑战性,因为数据集、训练技术、超参数等差异巨大,并且往往缺乏详细公开文档。

尽管如此,我认为审视架构的结构变化,仍然非常有价值——这能揭示 2025 年 LLM 开发者们的新动向。(下图展示了部分模型架构。)

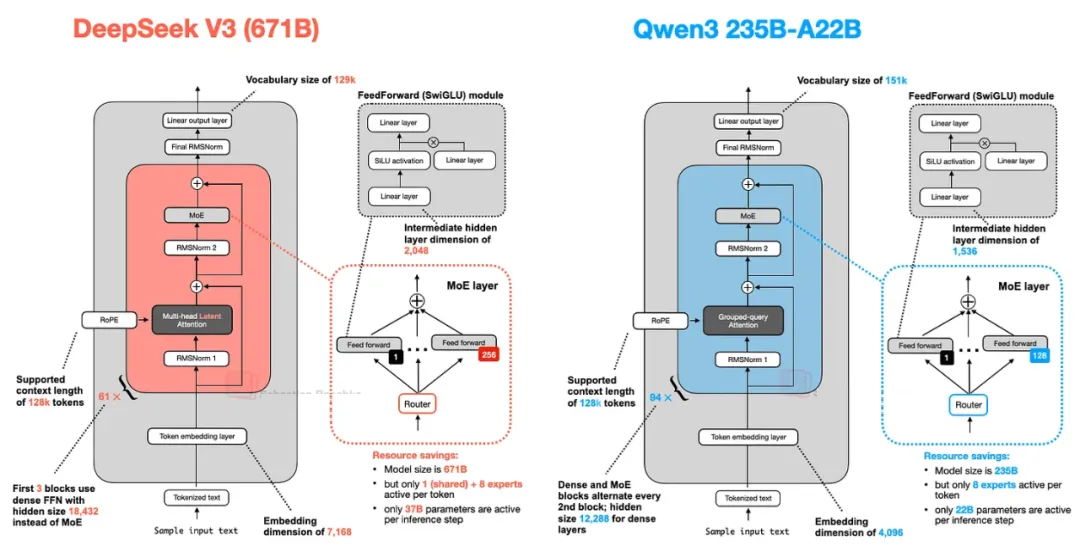

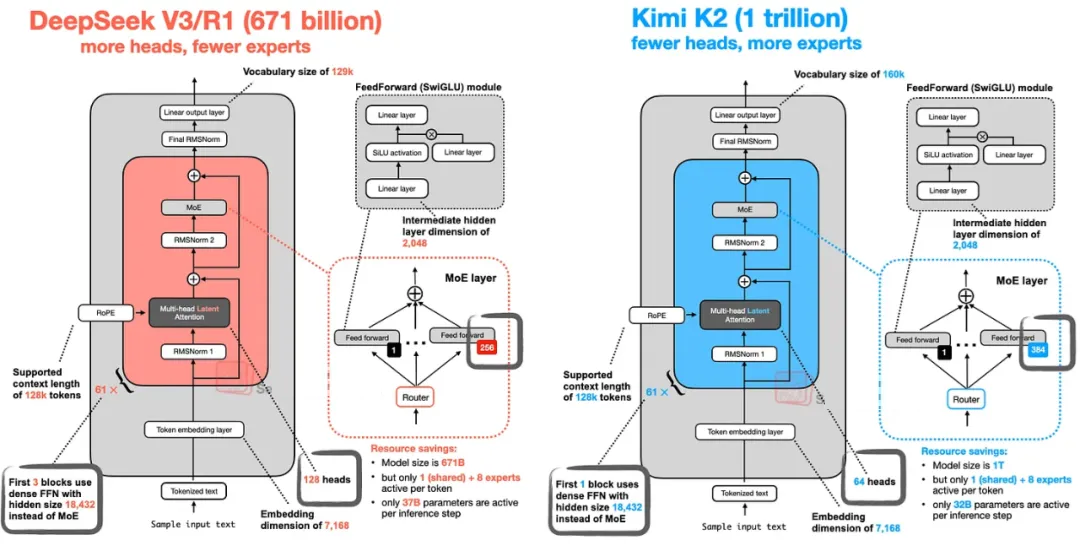

DeepSeek V3/R1

DeepSeek R1 在 2025 年 1 月发布时产生了巨大影响。R1 是一个推理模型,构建于

2024 年 12 月推出的 DeepSeek V3 架构之上。

本文主要聚焦于 2025 年的新架构,但我认为仍有必要将 DeepSeek V3 纳入讨论。

我将重点讲解 DeepSeek V3 中两项关键架构技术,这两者不仅提升了计算效率,还让其在众多 LLM

中脱颖而出:

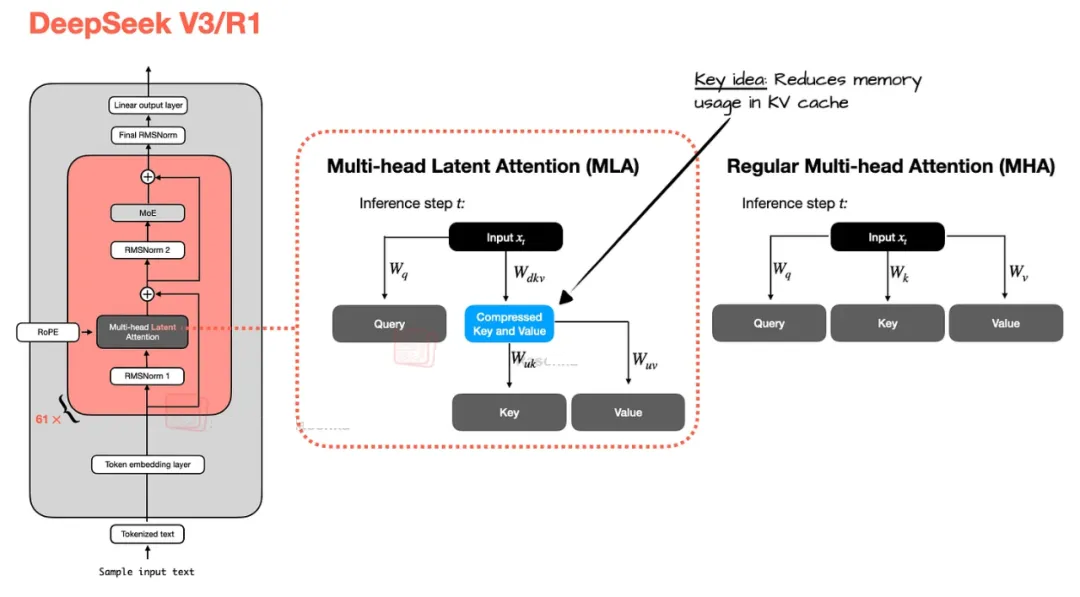

多头潜在注意力(MLA)

专家混合(MoE)

多头潜在注意力

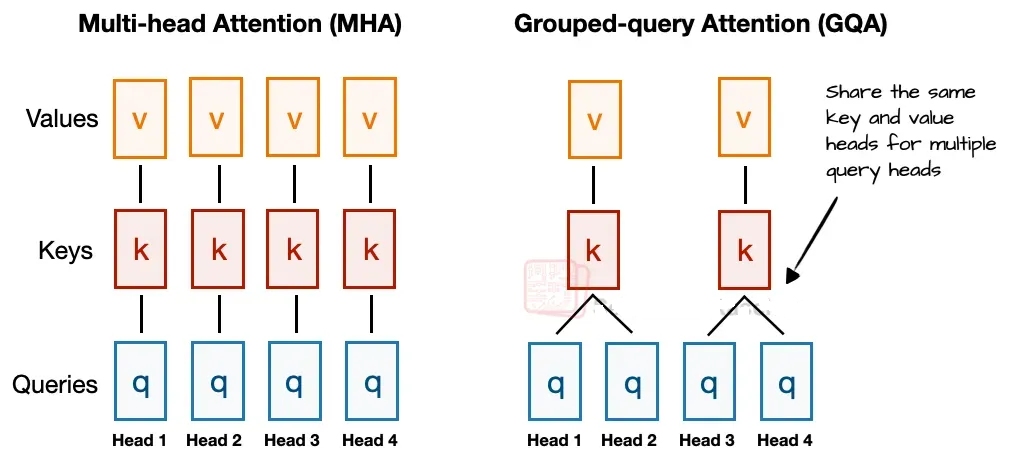

在深入介绍 MLA 之前,我们先回顾一下它为何出现。近年来,分组查询注意力(GQA)已成为取代 MHA

的新标准,以实现更高的计算和参数效率。

简单来说,GQA 与 MHA 的不同之处在于:MHA 中每个注意力头都有自己的 Key 和 Value,而

GQA 则将多头分组,共享同一组 Key 和 Value,从而减少内存使用。

如下图所示,若有 2 个 Key-Value 分组和 4 个注意力头,则头 1 和 2 共享一组 Key

和 Value,头 3 和 4 共享另一组。这降低了 Key 和 Value 的计算量,减少了内存带宽占用,同时保持了模型性能。

而 MLA 则采用了另一种内存节省策略:在存入 KV 缓存之前,将 Key 和 Value 张量压缩到低维空间,推理时再投影回原始维度(见下图)。这样做虽然增加了一次矩阵乘法,但内存使用量明显降低。

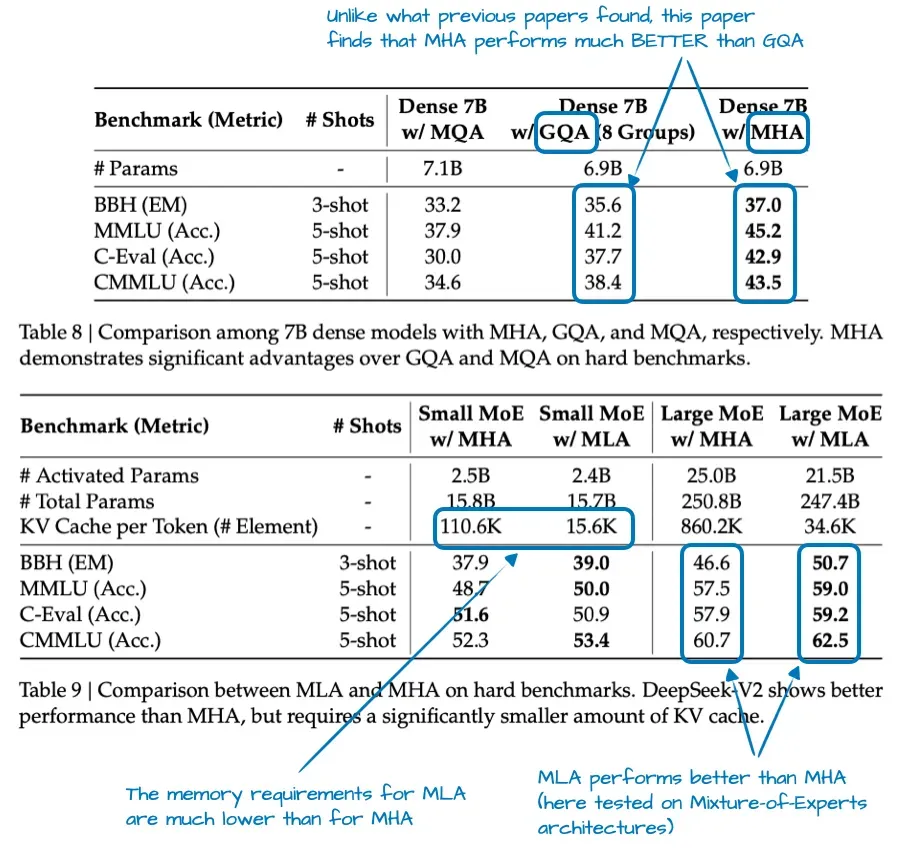

值得注意的是,MLA 并非首次出现在 DeepSeek V3。其实在 DeepSeek-V2 中,MLA

就已被引入。V2 的消融实验表明,MLA 在建模性能上优于 GQA,这也是 DeepSeek 团队最终选择

MLA 的原因(见下图)。

简言之,MLA 在减少 KV 缓存使用的同时,在建模性能上也略优于 MHA。

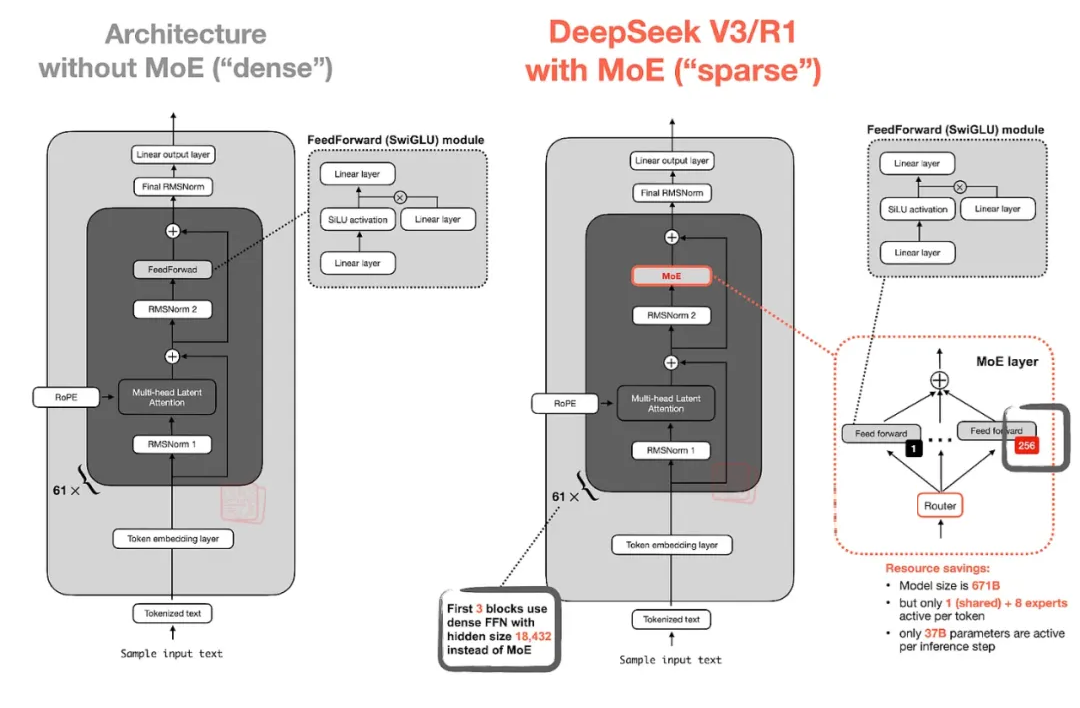

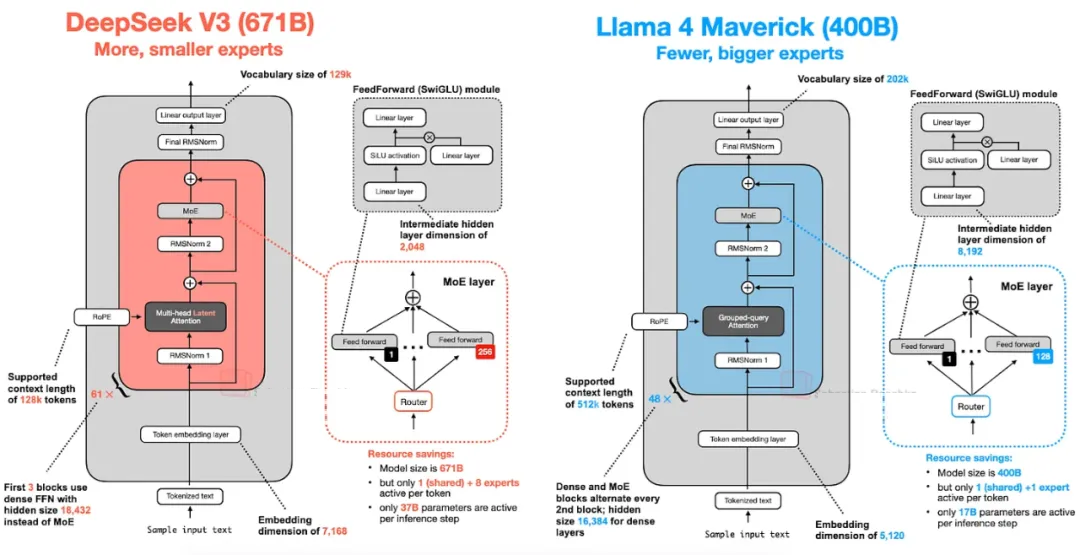

专家混合

另一项值得关注的架构创新是 DeepSeek 的 专家混合(MoE)。MoE 的核心思想是用多个专家前馈模块替换原有的单一前馈模块。在推理时,路由器只选择少数几个专家进行激活,这种“稀疏激活”策略使得大型模型在推理时依然高效。

例如,DeepSeek-V3 的每个 MoE 模块包含 256 个专家,总参数量达 6710 亿,但推理时只激活

9 个专家(1 个共享专家 + 路由器选择的 8 个专家),实际使用的参数量仅 370 亿。

共享专家(始终对每个 token 激活)最早出现在 DeepSeek-V3 的 MoE 论文中,并被证明有助于提升模型性能。DeepSeek

采用这一设计,是为了让共享专家专注于学习通用模式,从而使其他专家可以专注于更细分的模式。

小结

DeepSeek-V3 是一个参数量达 6710 亿的巨型模型,在发布时超越了包括 4050 亿参数的

Llama 3 在内的其他开源模型。其 MoE 和 MLA 技术不仅在推理效率上表现出色,建模性能也优异。

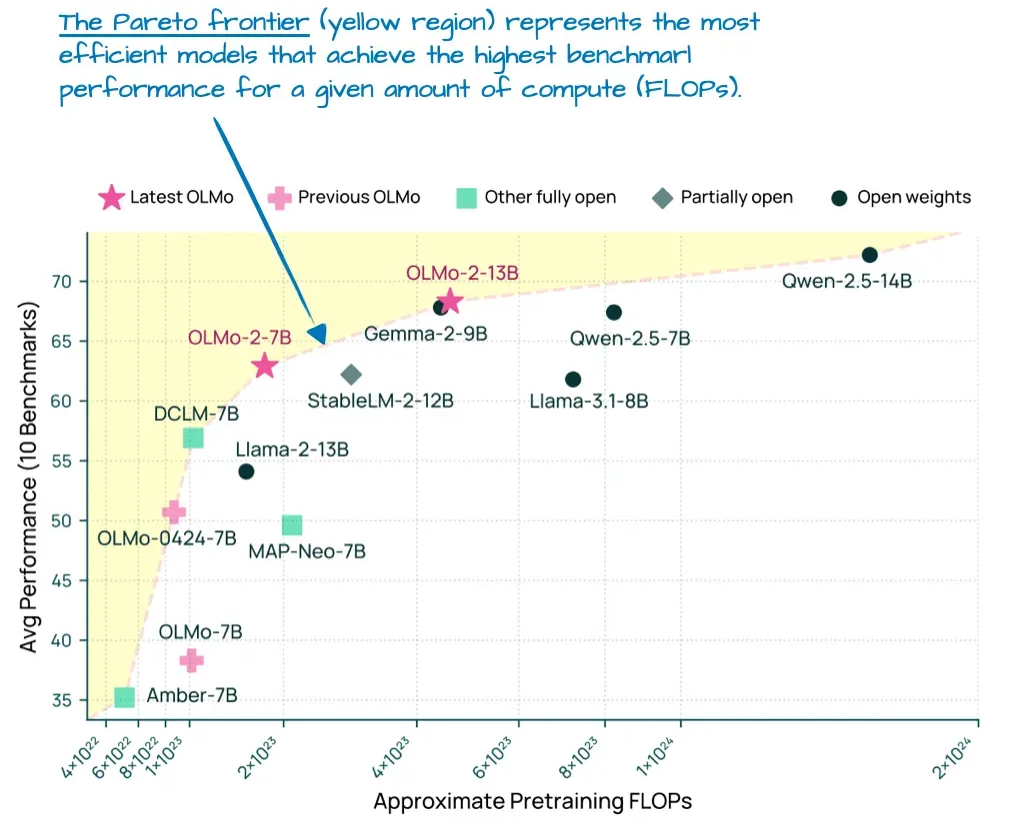

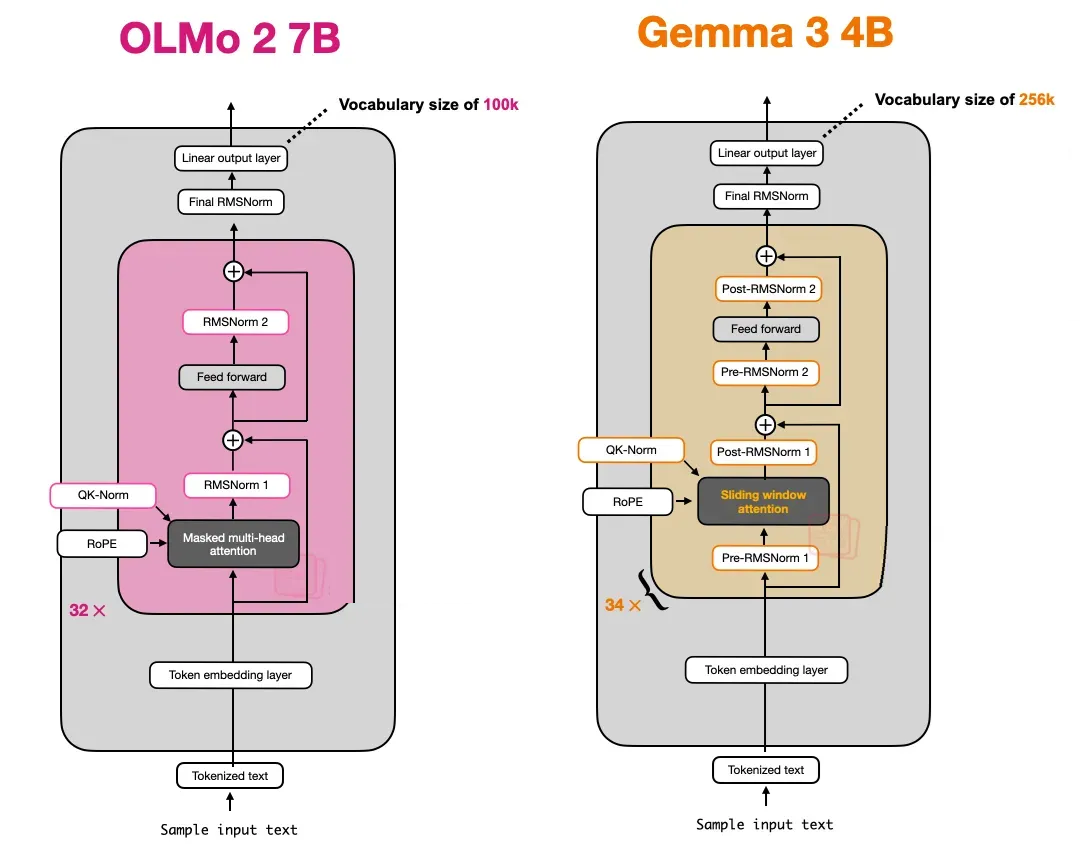

OLMo 2

OLMo 2 在 2025 年 1 月发布时,虽然在基准测试中不是第一,但其计算成本与性能的平衡位于帕累托前沿(见下图)。

OLMo 2 的架构亮点主要在于:

RMSNorm 的归一化层位置调整;

QK-Norm(对 Query 和 Key 在 RoPE 之前进行归一化);

依旧使用传统的 MHA,而非 GQA 或 MLA。

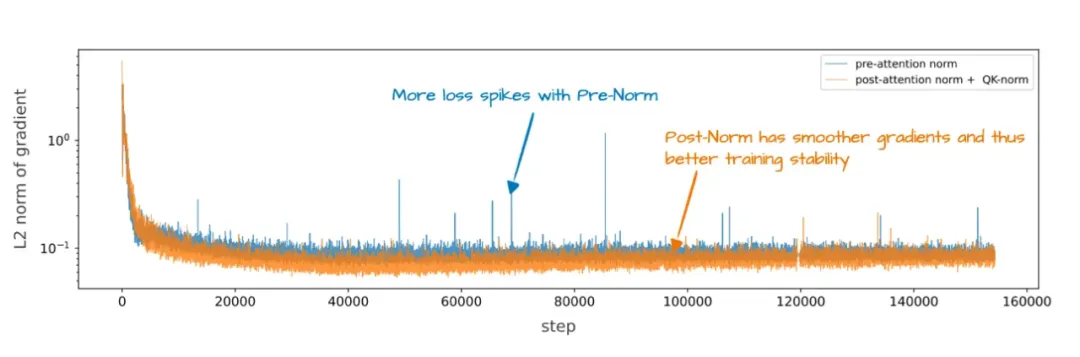

归一化层位置

OLMo 2 采用了一种“后归一化”(Post-Norm)策略:将 RMSNorm 放置在注意力模块和前馈模块之后,而不是像

GPT-2 和 Llama 那样采用“前归一化”(Pre-Norm)。

这种做法有助于提升训练稳定性(见下图)。

QK-Norm

QK-Norm 本质上是一个应用于 Query 和 Key 的 RMSNorm 层,放置在 RoPE

之前,这一做法最早出现在 2023 年的《Scaling Vision Transformers》论文中。

QK-Norm 与 Post-Norm 的结合,显著改善了训练损失曲线的平滑性和模型的收敛性。

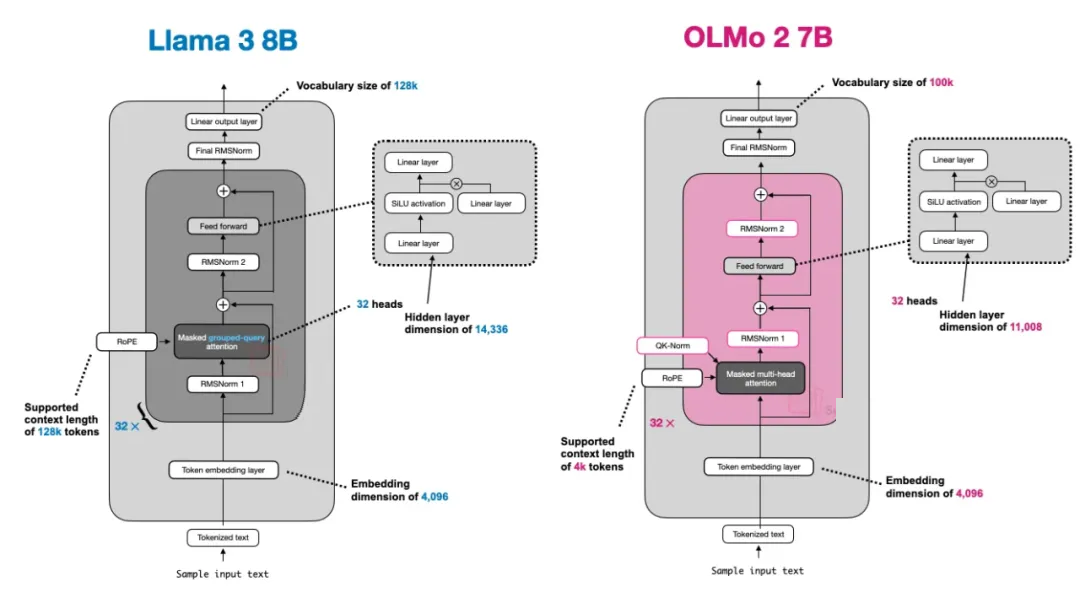

小结

OLMo 2 在架构设计上最显著的创新是:

使用 Post-Norm(RMSNorm);

引入 QK-Norm;

保持传统 MHA 设计。

与 Llama 3 相比,OLMo 2 除了这些细节差异,整体结构高度相似(见下图)。

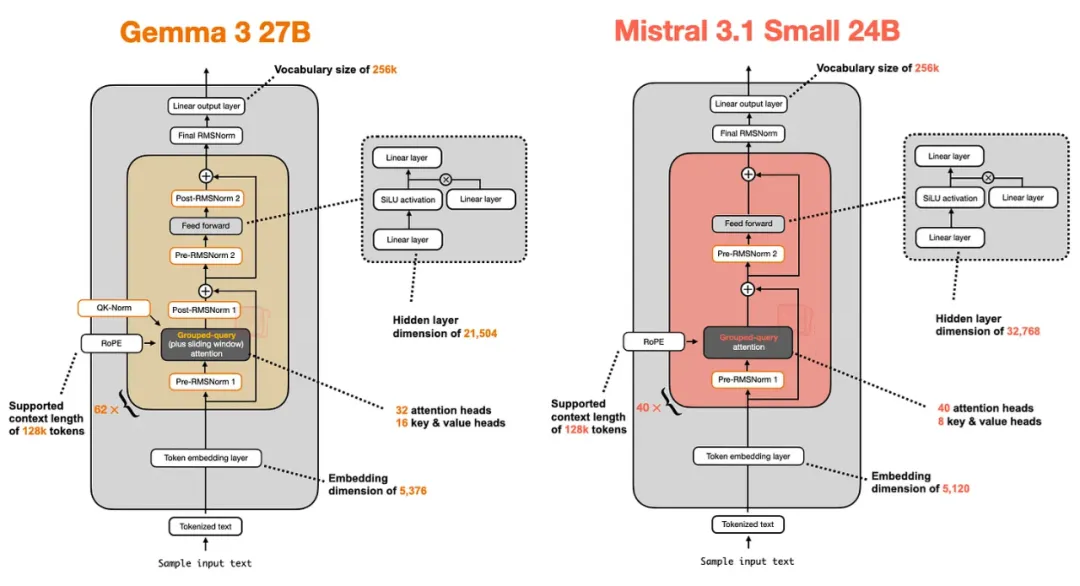

Gemma 3

Gemma 的一个显著特征是其相对较大的词汇表规模,能更好地支持多语言场景。此外,Google 对

27B 参数的模型投入更多(相比 8B 或 70B),但 Gemma 2 也提供了较小规模的版本:1B、4B

和 12B。

27B 这个规模达到了一个“甜点区”:它比 8B 模型更强大,但不像 70B 模型那样资源消耗巨大。

那么,Gemma 3 还有哪些值得关注的地方呢?之前提到过,其他模型(如 DeepSeek-V3/R1)采用

MoE 架构来降低推理内存需求,而 Gemma 3 采用了另一种“技巧”来减少计算成本:滑动窗口注意力(Sliding

Window Attention)。

滑动窗口注意力

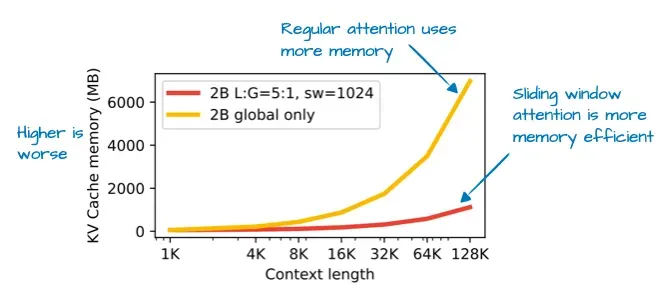

滑动窗口注意力最早在 2020 年的 LongFormer 论文中提出,并且已在 Gemma 2 中使用。Gemma

3 团队通过这种方法,大幅降低了 KV 缓存的内存需求(见下图)。

那什么是滑动窗口注意力?

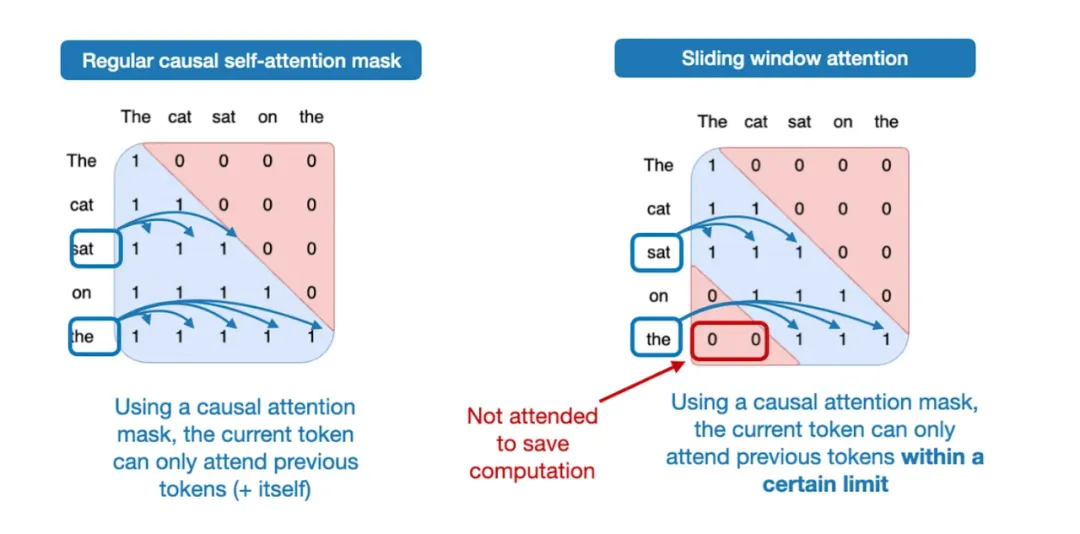

传统自注意力机制是全局的,每个序列元素都可以访问序列中的其他所有元素。

滑动窗口注意力则是局部的,它限制每个查询位置的上下文范围,仅允许访问当前位置附近的 token(见下图)。

值得注意的是,滑动窗口注意力既可与传统 MHA 配合,也可与 GQA 配合;Gemma 3 选择了

GQA。

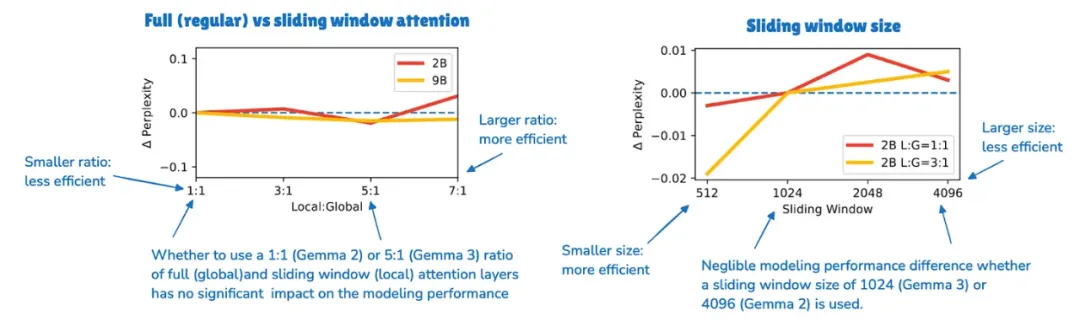

Gemma 2 采用了“混合注意力机制”:在每两层 Transformer 中,交替使用滑动窗口(局部)注意力和全局注意力,比例为

1:1。每个 token 可在 4k-token 的窗口中查看上下文。

而 Gemma 3 将这一比例调整为 5:1,即每 5 层滑动窗口注意力后才插入 1 层全局注意力,同时将滑动窗口大小从

4096(Gemma 2)缩减到 1024(Gemma 3)。这种调整让模型更偏向高效的局部计算。

根据消融实验,滑动窗口注意力对建模性能影响甚微(见下图)。

Gemma 3 中归一化层的位置

一个小但有趣的细节是:Gemma 3 在 GQA 模块周围同时使用了 Pre-Norm 和 Post-Norm

的 RMSNorm。

这与 Gemma 2 类似,但值得再次强调,因为它区别于:

原始 Transformer (“Attention is All You Need”) 的 Post-Norm;

GPT-2 及许多后续架构流行的 Pre-Norm;

我们在 OLMo 2 看到的 Post-Norm 变体。

Gemma 3 的这种做法被认为是“取两者之长”,作者认为额外的归一化基本不会有负面影响,因为 RMSNorm

的计算消耗相对较低(见下图)。

小结

Gemma 3 是一个性能出色的开源 LLM,我认为在开源圈内仍被低估。它最有趣的特征是:

使用滑动窗口注意力显著提高效率;

独特的归一化层布局(Pre-Norm + Post-Norm)。

未来,如果能将滑动窗口注意力与 MoE 结合,可能会产生更高效的架构。

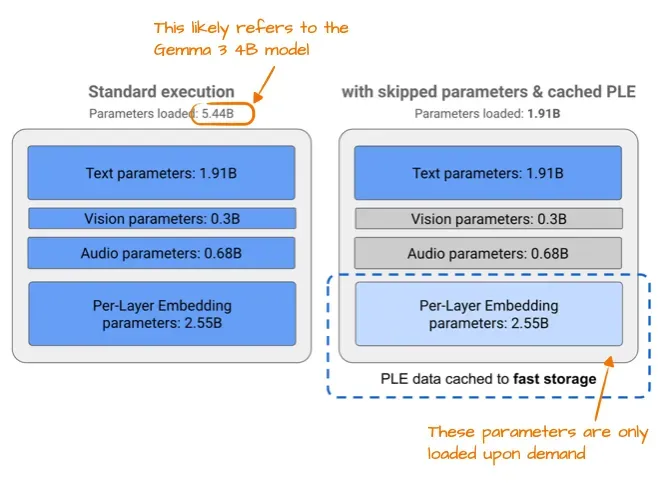

Gemma 3n

几个月后,Google 发布了 Gemma 3n,这是专为小型设备优化的版本,目标是能在手机上运行。

其中一项优化是 Per-Layer Embedding(PLE):仅将部分模型参数保留在 GPU 内存中,而针对文本、音频和视觉模态的特定嵌入则按需从

CPU 或 SSD 流式加载(见下图)。

此外,Gemma 3n 还引入了 MatFormer:一个单一共享的 Transformer 架构可切分为多个较小的、独立可用的模型。每个切片都经过独立训练,推理时可仅运行所需部分,而无需加载整个大模型。

Mistral Small 3.1

Mistral Small 3.1(24B 参数)于 2025 年 3 月发布,紧随 Gemma 3

之后。它在多个基准测试上超越了 Gemma 3(27B 参数),尤其在推理速度上更快(除数学任务外)。

Mistral Small 3.1 的低延迟得益于:

定制 Tokenizer;

缩减 KV 缓存规模;

降低 Transformer 层数。

它的架构整体较为标准(见下图)。

值得一提的是,早期 Mistral 模型曾使用滑动窗口注意力,但在 Mistral Small 3.1

中放弃了这一设计。推测原因可能是:

虽然滑动窗口注意力减少了内存使用,但并不一定降低推理延迟。而采用标准 GQA 则允许使用如 FlashAttention

等高度优化的计算方法,进一步提升速度。

Llama 4

Llama 4 也采用了 MoE 架构,并在总体设计上与 DeepSeek-V3 类似(见下图)。

两者的显著区别:

Llama 4 使用 GQA,而非 DeepSeek-V3 的 MLA;

Llama 4 的 MoE 设计更为传统:每次激活 2 个较大专家(隐藏层大小 8192),而 DeepSeek-V3

每次激活 9 个较小专家(隐藏层大小 2048);

DeepSeek 在除前三层外的每层都使用 MoE,而 Llama 4 每两层交替使用 MoE 和密集模块;

DeepSeek-V3 总参数量约为 Llama 4 Maverick 的 1.68 倍,但在推理时活跃参数量也高出一倍多(DeepSeek-V3

为 37B,Llama 4 Maverick 为 17B)。

总的来看,2025 年 MoE 架构的流行是一个显著趋势,而 Llama 4 是该趋势的重要体现。

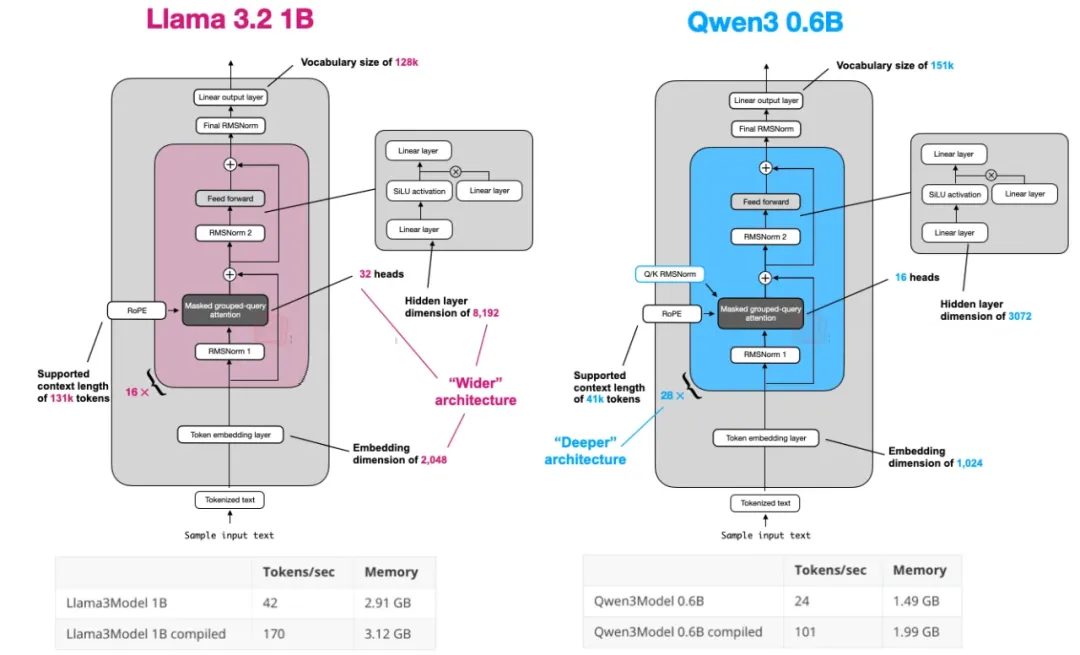

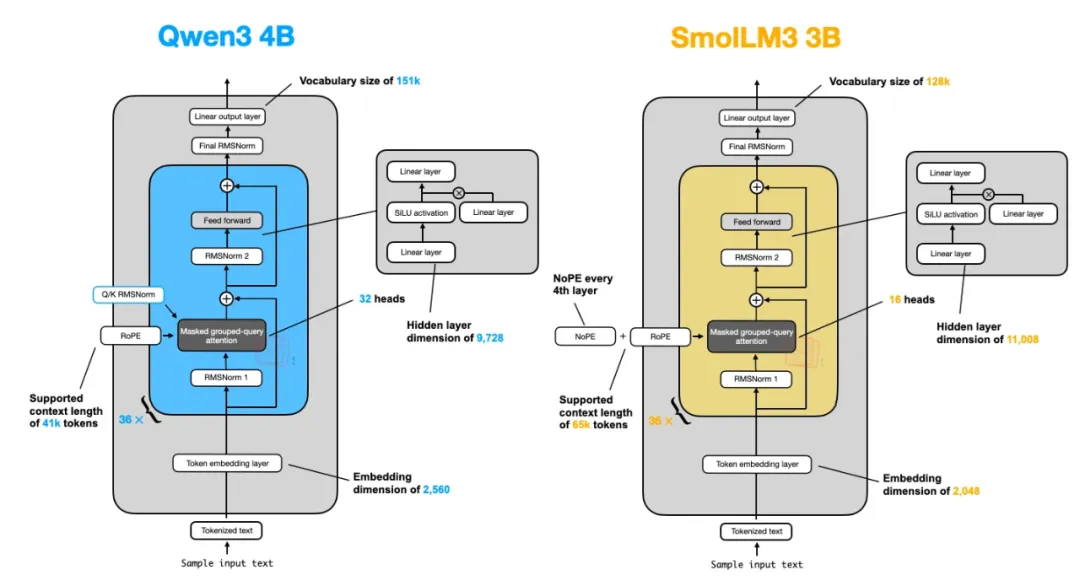

Qwen3

Qwen 团队一贯推出高质量的开源 LLM。Qwen3 是该团队又一力作,一经发布迅速跻身各参数规模排行榜的前列。该系列包含:

7 个密集模型:0.6B、1.7B、4B、8B、14B 和 32B

2 个 MoE 模型:30B-A3B 和 235B-A22B

密集模型

截至目前,Qwen3 0.6B 很可能是最新一代开源 LLM 中最小的模型。在我个人测试中,它的表现相当不错:在小尺寸的同时,具备很高的

tokens/sec 吞吐量和低内存占用,适合本地运行。它也是教育用途的理想选择,因为训练成本低。

我甚至已经在许多场景中用 Qwen3 0.6B 替代了 Llama 3 1B。下图展示了这两者的架构对比:

Qwen3 更深(更多 Transformer 层数)

Llama 3 更宽(更多注意力头)

在 A100 GPU 上运行的纯 PyTorch 实现测试结果显示,Qwen3 的内存占用更小,但因层数更多,生成速度略慢。

MoE 模型

正如前文提到,Qwen3 同时提供两种 MoE 版本:30B-A3B 和 235B-A22B。

为什么要同时推出密集和 MoE 模型?

密集模型更易于微调、部署和在各种硬件上优化。

MoE 模型则专为推理效率优化。在固定推理预算下,MoE 能在不显著增加推理成本的前提下,实现更高模型容量(即训练期间吸收更多知识)。

例如,Qwen3 235B-A22B 的活跃参数量为 22B,相比之下 DeepSeek-V3 的活跃参数量为

37B(见下图)。两者架构非常相似,但 Qwen3 已不再采用共享专家(此前的 Qwen2.5-MoE

使用过)。

关于放弃共享专家的原因,Qwen3 团队成员林俊旸回应:“我们当时没有发现共享专家带来足够显著的提升,同时还担心它可能影响推理优化。坦白讲,这个问题并没有明确答案。”

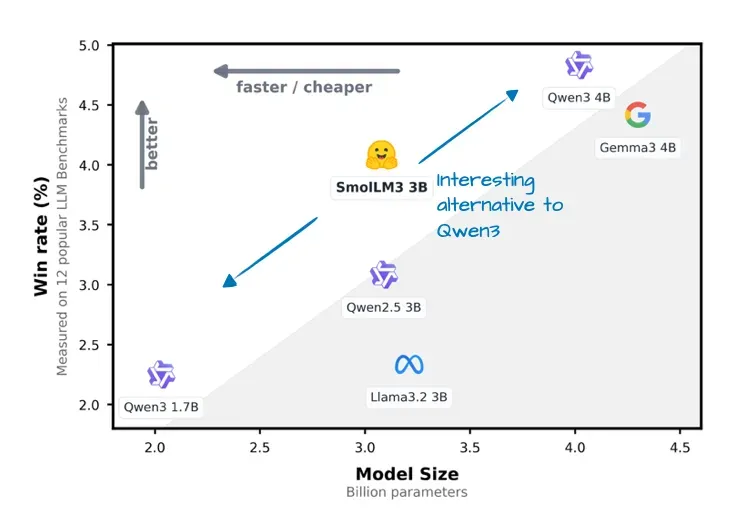

SmolLM3

虽然 SmolLM3 的知名度不及其他 LLM,但它以3B 参数规模在小模型领域表现出色,介于 Qwen3

的 1.7B 和 4B 之间(见下图)。

SmolLM3 也分享了丰富的训练细节,这在开源模型中极为罕见。

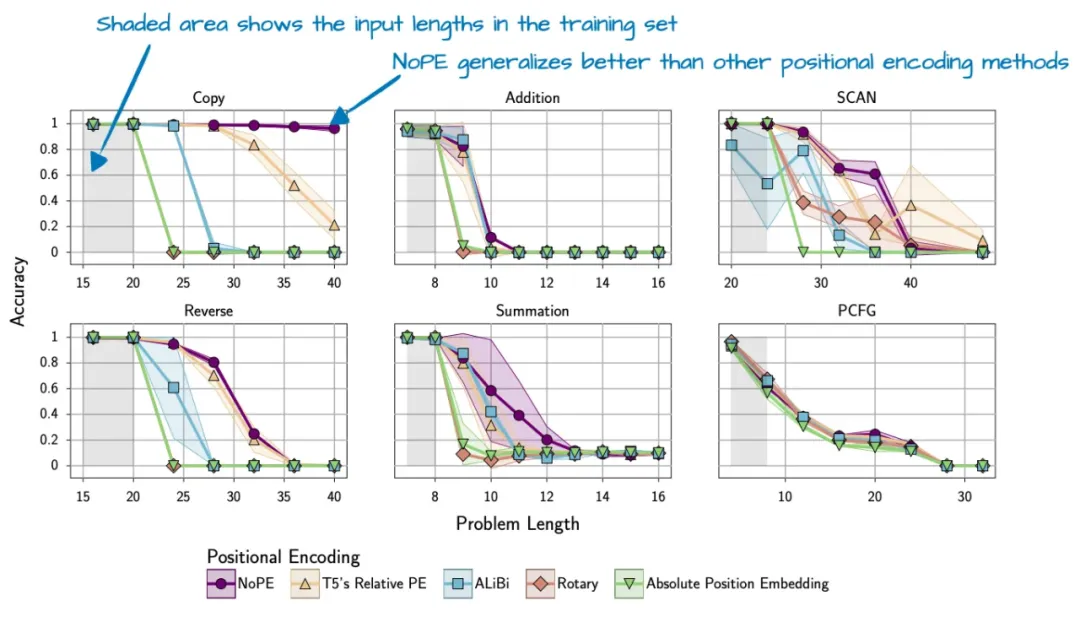

SmolLM3 最有趣的特征是无位置嵌入(NoPE)。

在 Transformer 中,位置编码通常是必要的,因为自注意力机制本身并不感知 token 顺序。早期

GPT 架构使用绝对位置嵌入,现代模型(如 RoPE)则采用旋转位置嵌入。

而 NoPE 完全省略了位置嵌入层,模型仍可通过因果注意力掩码维持 token 顺序:每个 token

只能关注当前位置及之前的位置。

NoPE 的优势在于更好的长度泛化能力(即在处理更长序列时性能下降更少,见下图)。不过,这些结果基于较小模型(约

1 亿参数)和较短上下文窗口,尚不确定在现代大型 LLM 中是否同样适用。

因此,SmolLM3 团队选择每隔 4 层省略一次位置嵌入,而非完全取消 RoPE。

Kimi K2

Kimi K2 最近在 AI 社区引发巨大关注——它是一款性能媲美 Google Gemini、Anthropic

Claude 和 OpenAI ChatGPT 的开源模型。

参数量高达 1 万亿,可能是当代最大规模的 LLM(Llama 4 Behemoth 尚未发布,Google

的 Switch Transformer 属于不同代际的编码器-解码器架构)。

Kimi K2 基于 DeepSeek-V3 架构,但进一步扩展:

MoE 模块中专家数量更多

MLA 模块中注意力头数略少(见下图)

Kimi K2 的前身 Kimi 1.5 也曾表现亮眼,但由于发布与 DeepSeek R1 同一天,且权重未公开,因此影响力有限。Kimi

K2 团队显然吸取了经验,及时发布了 K2 的开源权重,抢在 DeepSeek R2 之前赢得了关注。

Kimi K2 中 Muon 优化器的亮点:

Kimi K2 的训练中采用了 Muon 优化器(替代常用的 AdamW),这是首个在如此大规模模型上验证

Muon 可行性的案例。

训练损失曲线异常平滑(几乎无尖峰),显示出优化过程的优异表现。不过作者提醒,真正衡量训练稳定性时,梯度

L2 范数或许是更佳指标。

总结

2025 年的大模型架构创新呈现以下趋势:

MoE 的广泛采用

KV 缓存优化技术崛起(MLA、Sliding Window Attention)

归一化层布局调整(OLMo 2 和 Gemma 3 的不同策略)

新优化器尝试(Kimi K2 的 Muon)

未来,我们可能看到这些技术进一步融合,比如将滑动窗口注意力与 MoE 结合,或是在手机级硬件上运行

100B 级模型。

|