| 编辑推荐: |

本文通过约束解码技术,赋予大型语言模型在生成SQL等结构化内容时更高的准确性、可控性与可解释性,从而满足企业级场景对“精准生成”的严苛要求。希望对你的学习有帮助。

本文来自于微信公众号阿里云开发者 ,由火龙果软件Linda编辑,推荐。 |

|

阿里妹导读

本文旨在通过约束解码技术,赋予大型语言模型在生成SQL等结构化内容时更高的准确性、可控性与可解释性,从而满足企业级场景对“精准生成”的严苛要求。

引言

大型语言模型(LLM)在自然语言处理和代码生成方面取得了显著进展。然而,在生成高度结构化的数据(如SQL查询)时,它们仍然面临挑战。无约束的生成往往导致语法错误或不符合特定数据库模式及业务逻辑约束的查询,这在需要精确执行的环境中是不可接受的。此外,实际应用场景常常要求对生成过程施加干预,例如强制模型在筛选条件中一定要使用特定列或应用预定义的过滤条件(where

xxx = xxx),又或者说强制模型在生成SQL时带上LIMIT限制,防止造成数据库水位上升。而标准LLM生成流程缺乏对此类细粒度控制的有效机制,就算我们在prompt里要求模型这么做,大模型也没有办法保证100%符合我们的要求。别的不说,有图有真相:

《完蛋!我被LLM包围了!》游戏截图[1]

一次强行要求模型回答某个内容的测试

第一个截图是当时很经典的一个模型输出游戏,它展示了提示词的一些局限性,不过其实现在这个问题,同样的prompt,qwen2.5max已经是可以正确回答了。第二个截图则是新鲜测试的场景,模型也没有按照“要求”去输出。

回到sql上,当用户把“在查询xx指标时,一定要使用a字段”这句话放入prompt时,他不一定可以得到一个拥有a字段筛选的SQL。而对于客户来说,它们最直接的干预sql形式,便是类似这样的表达。

因此,一个核心问题随之产生:我们能否设计一种机制,确保LLM生成的SQL不仅在语法上100%合规,而且能够严格遵循用户定义的任意约束?换言之,能否将形式语法的严谨性和自定义规则的灵活性,直接集成到LLM的解码(Decoding)阶段?

正文

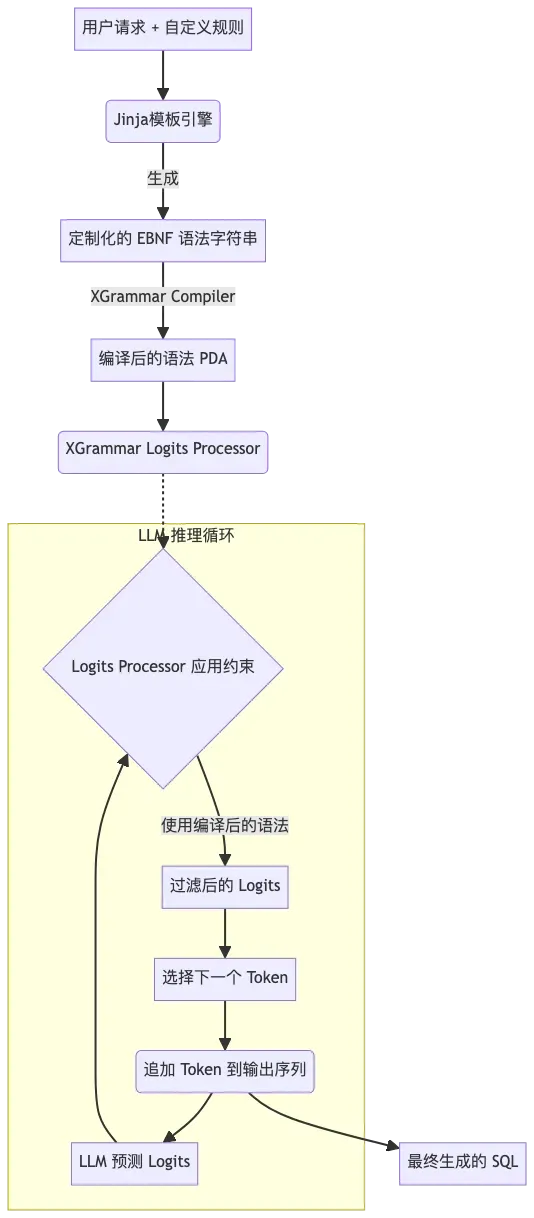

本文介绍了一种基于约束解码(Constrained Decoding) 技术的解决方案,旨在应对上述挑战。我们提出了一种方法,通过结合上下文无关文法(Context-Free

Grammar, CFG) 来形式化定义SQL语法,利用Jinja模板引擎动态生成符合特定需求的扩展巴科斯范式(EBNF)

语法规则,并借助高效的XGrammar框架来解析和执行这些语法约束。

该方法的核心思想是在LLM生成每个token时,实时地过滤掉不符合当前语法状态和自定义约束的候选token,从而引导模型仅在合规的路径上进行探索。这相当于在LLM内部嵌入了一个轻量级但功能强大的“SQL语法和规则校验器”。通过这种方式,我们不仅能保证输出SQL的语法正确性,还能实现对查询结构的精细控制,包括但不限于:限定查询的表源、强制包含特定过滤条件、约束聚合函数的使用、甚至定义GROUP

BY子句的列组合模式等。

接下来的内容将详细阐述该方案的技术实现细节、所采用的关键组件(如XGrammar的工作原理、Jinja模板的应用),展示其在实际场景中的效果,并探讨其相较于传统方法的优势与潜在应用。让我们深入了解如何将结构化生成的约束能力,高效且灵活地赋予大型语言模型。

像内置编辑器一样工作:

理解 Constrained Decoding

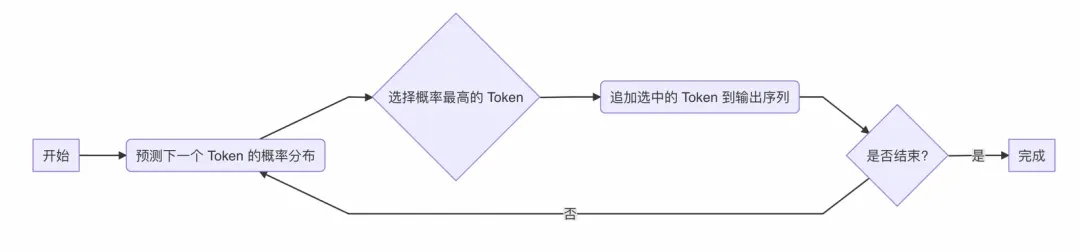

让我们先看看大模型(LLM)通常是如何“写东西”的。想象它是一位即兴的作家,每次只写一个词块(Token)。LLM

通常不是一个字母一个字母地生成,而是以“词”或“词块”(这些单元统称为 Token)为单位进行预测和生成。它写下第一个

token 后,会根据这个 Token 预测最可能出现的下一个 Token,然后写下它;接着再根据已有的两个

Token,预测第三个 Token……如此循环往复。这个过程,技术上称为自回归解码(Autoregressive

Decoding)。

图 1: 贪心自回归解码流程

这种方式非常适合生成流畅自然的文本,比如聊天、写文章。但如果我们要求这位作家写一段精确的 SQL

查询语句,麻烦就来了。SQL 语法非常严格,就像精确的工程蓝图,每个符号、每个关键字的位置和顺序都有规定。这位即兴作家很可能会“灵感迸发”,写出不符合语法的组合(比如

SELECT 后面直接跟 WHERE),或者忘记了括号需要闭合,导致生成的 SQL 根本无法在数据库中执行。

更进一步,我们常常不仅需要语法正确,还想给这位作家设定一些“硬性规定”,比如:“你必须从 dm_sales.product_sales_daily

这张表查询数据!”或者“查询结果必须包含 fstore_type 字段,并且 fstatus 必须等于

1!”。标准的自回归解码机制对此无能为力,它只关心生成语言上的“通顺度”。

这时,我们就需要给这位作家配备一个随身的“SQL 编辑器”——这就是 Constrained Decoding(约束解码)的核心理念。

什么是 Constrained Decoding?

简单来说,Constrained Decoding 就是在 LLM 每一次要决定写下哪个 token

的时候,我们启动这个内置的“SQL 编辑器”。这个编辑器手握一本“SQL 语法大全”以及我们为本次任务定制的“项目规范”。这本“语法大全”通常是用上下文无关文法(Context-Free

Grammar, CFG) 来形式化定义的——CFG(我们这里用EBNF [2]的格式来书写)就像是一本精确定义了

SQL 语法规则的‘语法书’,它规定了哪些 token 组合是合法的。

在 LLM 给出所有它认为可能的下一个 token 的选项后,“SQL 编辑器”会介入,拿着这本“语法书”和“项目规范”,逐一审查:

1.语法检查: 选择这个 token,会不会违反 SQL 语法规则?(例如,在 SELECT column1

之后,合法的下一个 token 可能是 ,、FROM,但绝不可能是 WHERE)。

2.规范检查: 选择这个 token,是否符合我们设定的项目规范?(例如,如果规定了只能查询 table_A,那么模型就不能选择

table_B 作为表名)。

任何不符合语法或规范的 token,都会被这个“编辑器”直接“标红”或“禁用”,LLM 根本没有机会选择它们。

就像编辑器在你打字时,实时地禁用了那些会导致语法错误或违反项目要求的按钮。

它是如何工作的?

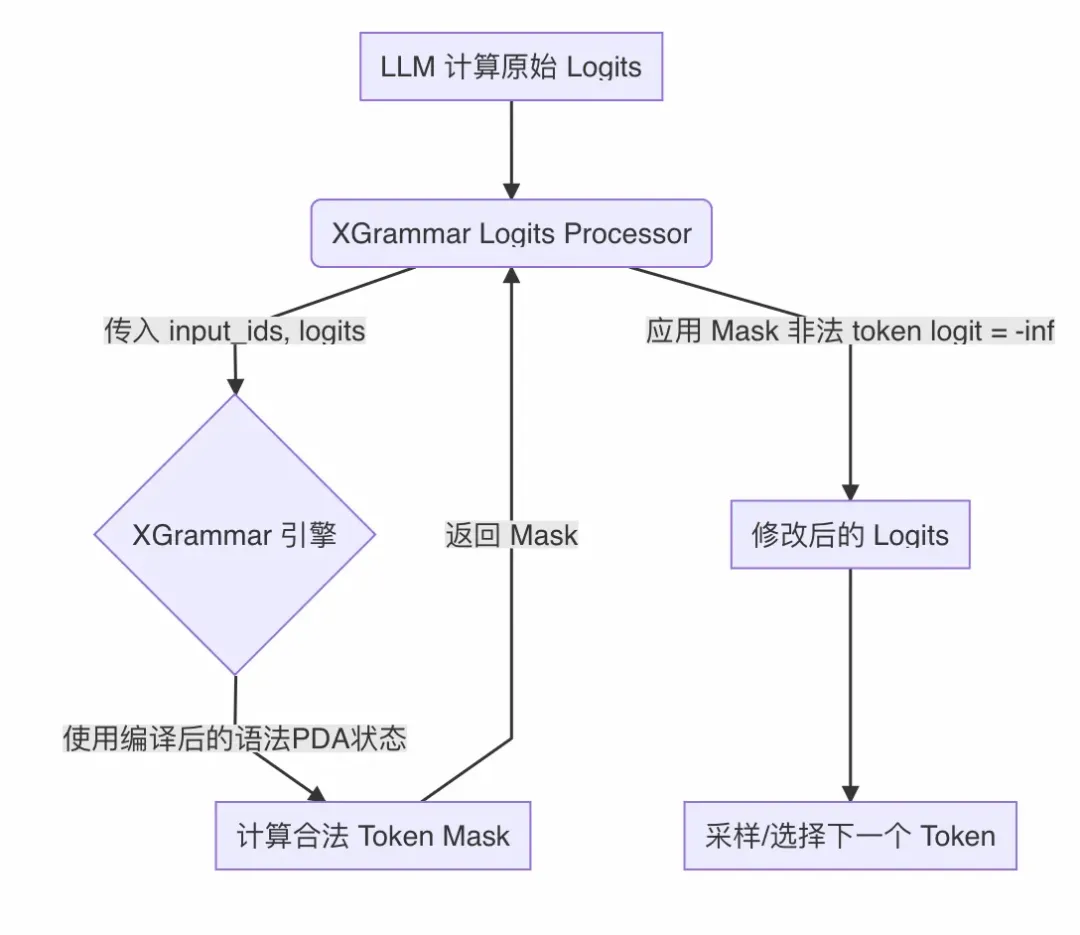

图 2: Constrained Decoding 流程(内置 SQL 编辑器,贪心采样)

1.预测: LLM 像往常一样,根据已生成的部分,预测出所有可能的下一个 token 及其概率。

2.检查与过滤: 内置的“SQL 编辑器”(由 XGrammar 等框架实现)启动,拿着预定义的

CFG 语法规则(我们的“语法书”)和自定义约束,快速检查 LLM 预测的所有候选 token。

3.屏蔽: 编辑器将所有不合规的 token 的概率设置为无效(例如,设为负无穷),确保它们在后续选择中被忽略。

4.选择: LLM 在那些通过了编辑器检查的、完全合规的 token 中,选择概率最高(或根据其他采样策略选择)的那一个。

5.重复: 这个“预测-检查过滤-选择”的循环在生成每一个 token 时都会进行,直到整个 SQL

语句构建完成。

打个比方:

这就像你在使用一个非常智能的代码编辑器写 SQL。当你输入 SELECT 后,编辑器会自动提示(或只允许你输入)合法的后续内容,比如列名、*

或函数。如果你试图输入 WHERE,编辑器会立刻阻止你,因为它知道这在语法上是错误的。同样,如果项目配置了这个编辑器,规定了必须使用

fstatus=1,那么在你写 WHERE 子句时,编辑器可能会自动帮你补全这部分,或者只允许你添加以

AND 开头的其他条件。

Constrained Decoding 的价值在于: 它赋予了 LLM 生成结构化数据的能力,使其输出(如

SQL 查询)不仅保证语法层面的绝对正确,还能严格遵循开发者施加的各种细粒度约束。这就像是给强大的

LLM 配备了一个严格、精准、且可定制的“格式与规则守护者”,确保其输出直接可用,无需担心基本的语法错误或违反关键业务规则。

当然,要在 LLM 高速生成 token 的同时,实时、高效地完成复杂的语法和规则校验,需要精巧的技术实现。接下来,我们将深入探讨如何利用

CFG、Jinja 模板以及 XGrammar 框架,构建出这个强大而高效的“内置 SQL 编辑器”。

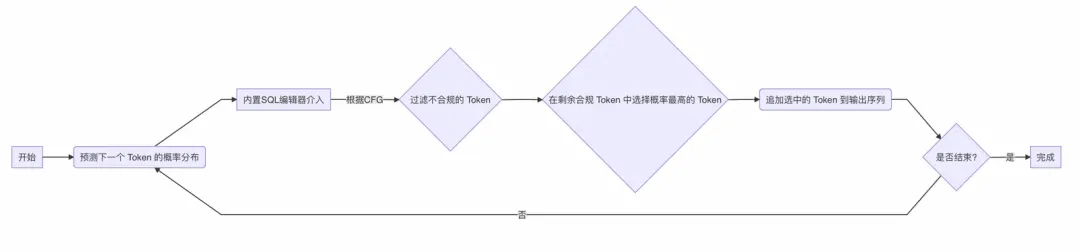

实现方案概述

为了构建这个“内置 SQL 编辑器”,我们整合了以下关键技术与组件,形成一套高效且灵活的约束生成流程:

1.上下文无关文法 (CFG): 使用 EBNF (扩展巴科斯范式) 作为形式化语言,精确定义目标

SQL 方言的语法结构。

2.Jinja 模板引擎: 动态生成 EBNF 语法规则。这允许我们在运行时根据用户请求的具体需求(如允许查询的表、必须包含的过滤条件、LIMIT

值等)定制语法。

3.XGrammar 框架: 一个高性能的 CFG 解析引擎。它负责将 EBNF 编译成高效的内部表示(Pushdown

Automata),并在 LLM 推理过程中快速判断哪些 token 符合当前的语法状态。

4.Hugging Face Logits Processor: 一个标准的接口,用于在 LLM

的每个解码步骤中修改 token 的概率分布 (logits)。我们将 XGrammar 的约束逻辑封装在此处理器中,实现对生成过程的实时干预。

整个流程可以概括如下:

图 3: 基于 XGrammar 和 Jinja 的动态约束 SQL 生成流程

技术细节

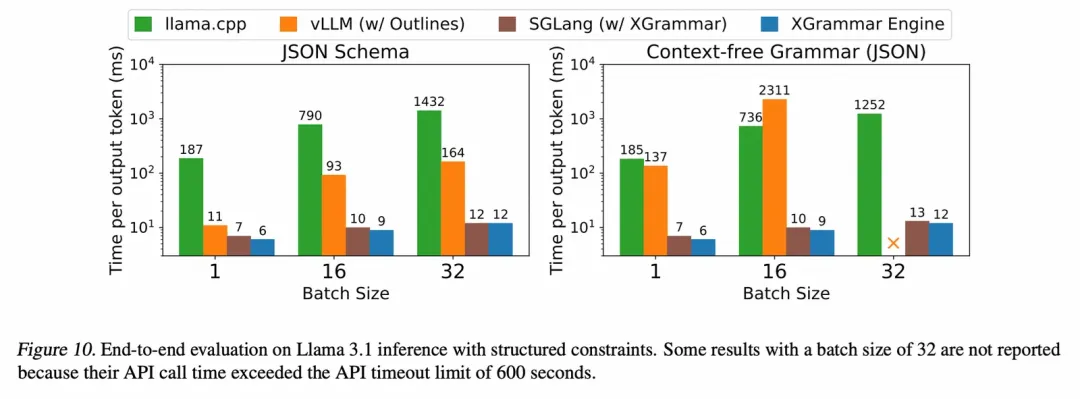

1. 约束解码框架的演进与 XGrammar 的优势

约束解码技术本身并非全新概念,业界已有一些探索和实现:

早期尝试 (如 Guidance): 较早期的框架,验证了通过模板和语法约束引导 LLM 生成的可能性,但在通用性、效率和易用性方面有提升空间。

主流框架 (如 Outlines): Outlines 是目前广泛使用的开源框架,它支持多种约束方式,包括正则表达式、JSON

Schema 以及 CFG。对于 CFG,它通常依赖如 Lark 这样的外部解析库,理论上可以支持

LALR(1) 等解析算法。然而,在实践中,为了处理 LLM tokenization 和增量生成带来的复杂性,其由社区贡献的CFG

实现可能面临性能挑战,尤其是在处理复杂或大规模语法时,就算目前的实现是仅使用第一个有效token,其性能也无法接受。同时,官方也强调了这只是一个实验性功能,见pull#1067[3](在我实验中测试,sql的cfg解析时间达到了平均

0.12s/token )

新一代高性能框架 (XGrammar): XGrammar 是一个专注于效率、灵活性和可移植性的较新框架(具体细节可参考官方博客文章[4]、技术报告[5])。它直接针对

CFG 约束解码的性能瓶颈进行了设计和优化。

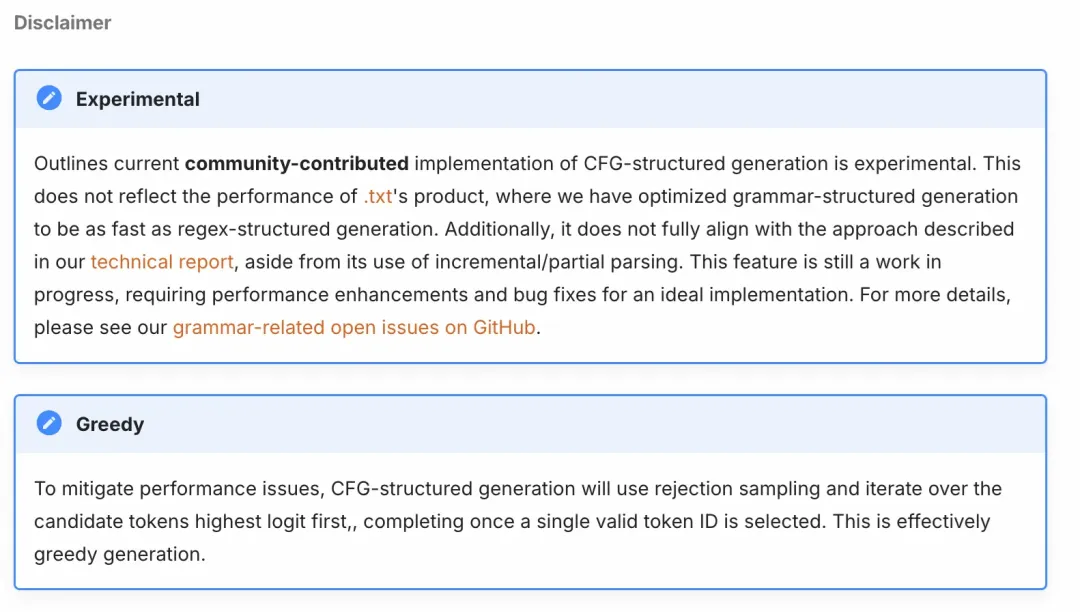

XGrammar 的核心原理与优化:

XGrammar 选择 下推自动机 (Pushdown Automata, PDA) 作为其执行

CFG 的核心机制。PDA 本质上是一个带栈的有限状态机,非常适合处理 CFG 定义的递归和嵌套结构(这在

SQL 中很常见)。

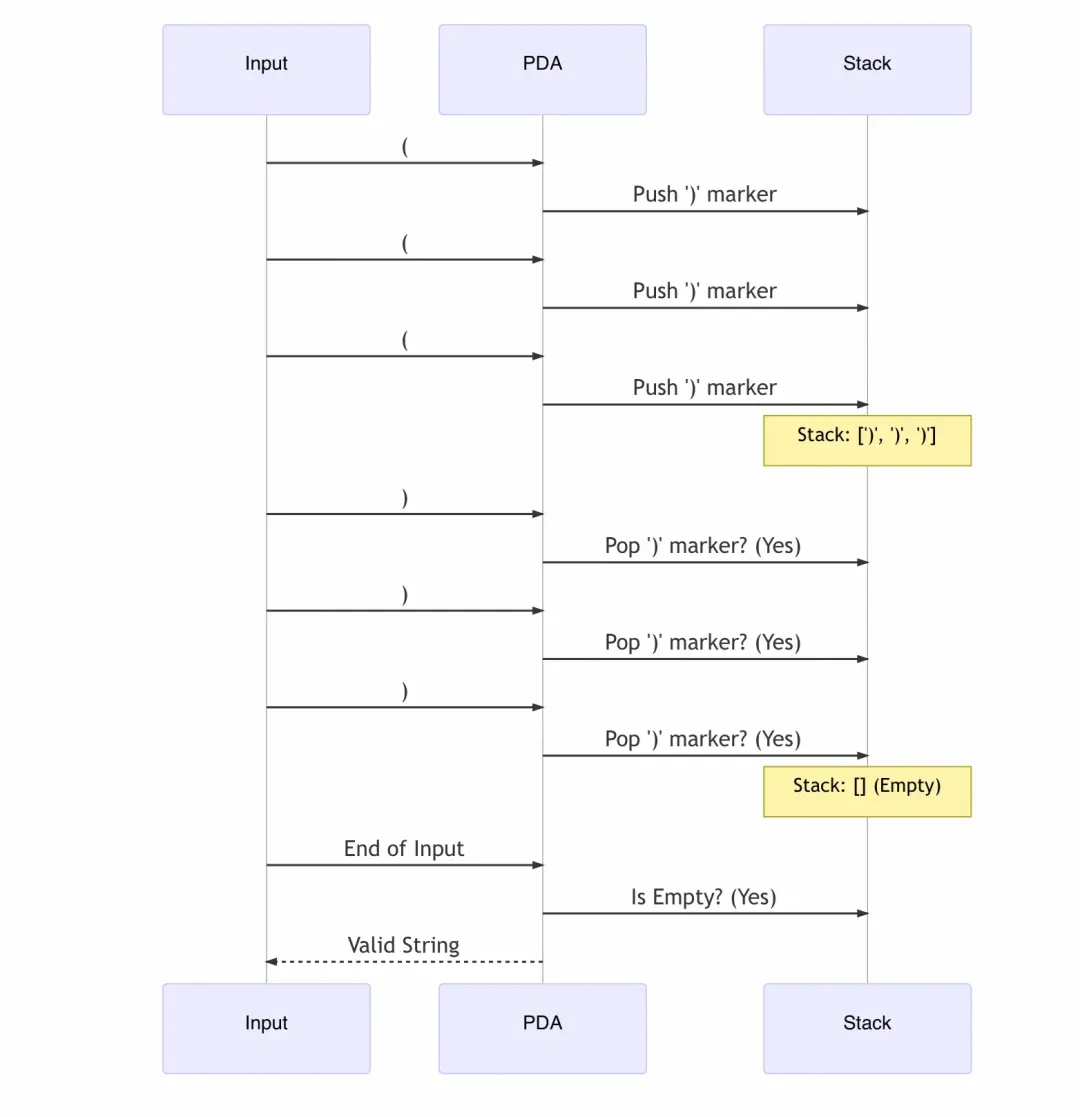

图 4: 简化的下推自动机 (PDA) 工作原理示意

为什么 PDA 对 CFG 高效? 因为它通过栈来管理规则的嵌套调用,避免了为无限可能的中间状态预计算所有情况。

让我们用一个简单的例子来说明:检查括号匹配,(如果大家平时有刷过leetcode,可以发现这是一个非常经典的栈使用的例子),比如

((()))。CFG 规则可以是 S ::= "(" S ")"

| ""。

如果试图预计算(类似 FSM 思路): 你需要一个状态来表示“有 0 个未闭合括号”,一个状态表示“有

1 个未闭合括号”,一个状态表示“有 2 个未闭合括号”... 由于括号可以无限嵌套,你需要无限个状态。这显然是不可行的,无法预先计算和存储所有这些“中间状态”。

PDA 的做法(使用栈): PDA 不需要无限状态。

1.遇到 (:它不改变状态来“记住”数量,而是在栈顶放一个标记(比如“需要右括号”)。栈记录了当前的嵌套深度。

2.遇到 ):它检查栈顶是否有标记。

有:匹配成功!把标记从栈顶弹出,表示一层嵌套完成了。

没有:错误!多余的右括号。

3.结束时:如果栈是空的,说明所有括号完美匹配。

图 4.1: PDA 使用栈处理 ((()))

PDA 通过动态地使用栈来跟踪嵌套层级(规则的递归调用 S ::= "(" S

")"),而不是为每种可能的嵌套深度(无限的中间状态)创建单独的状态。这就是它高效处理

CFG 的关键:用有限的状态 + 一个动态的栈,优雅地解决了无限状态空间的问题。

XGrammar 相较于 Outlines 等框架的关键优化点:

1.智能区分 Token (Context-independent/dependent Separation):

XGrammar 能聪明地识别出:哪些 token 的合法性只跟当前的语法位置有关(绝大多数情况),哪些则需要回头看整个“调用栈”历史才能确定(少数复杂情况)。这避免了对所有

token 都进行复杂的检查。

2. 预先计算与缓存 (Adaptive Token Mask Cache): 对于那些只跟当前位置有关的

token,XGrammar 在“编译”语法时就预先算好它们在什么位置是合法的,并把结果存起来。运行时,对于这些

token,直接查表就行,速度极快!

3. 高效管理多条路径 (Persistent Execution Stack): 当语法存在多种可能性时(比如

WHERE 后面可以跟 a=1 或 b=2),PDA 需要同时探索这些路径。XGrammar 使用一种聪明的树状数据结构来高效地管理这些并行的“探索路径”(栈),避免了低效的复制和回溯操作。

4.PDA 结构优化: 像编译器优化代码一样,XGrammar 会优化 PDA 的内部结构,比如合并等价的状态,让整个“语法检查机器”更小、更快。

5.并行编译: 利用多核 CPU 并行处理 EBNF 的编译过程,缩短准备时间。

6.计算重叠: 将 CPU 上的语法检查计算与 GPU 上的 LLM 推理计算安排得像流水线一样,尽量让它们同时进行,从而隐藏

CPU 的开销。

这些优化使得 XGrammar 在处理通用 CFG 时,相比传统实现能达到显著的性能提升(如官方报告中高达

10 倍以上的加速),目标是实现“零开销”的约束生成。

尽管如此,XGrammar 自身也存在挑战,例如对左递归的处理、非终结符过多可能导致的性能下降等问题(见

issue 127[6]、#203[7]),这也是我们后续需要关注和改进的地方。在我们的初步测试中,XGrammar

表现出潜力,但在测试过程中,对于复杂的CFG,也遇到了性能瓶颈(1.83s/token),目前我的解决方式是在CFG中尽可能避免递归表达,改为平铺的方式。

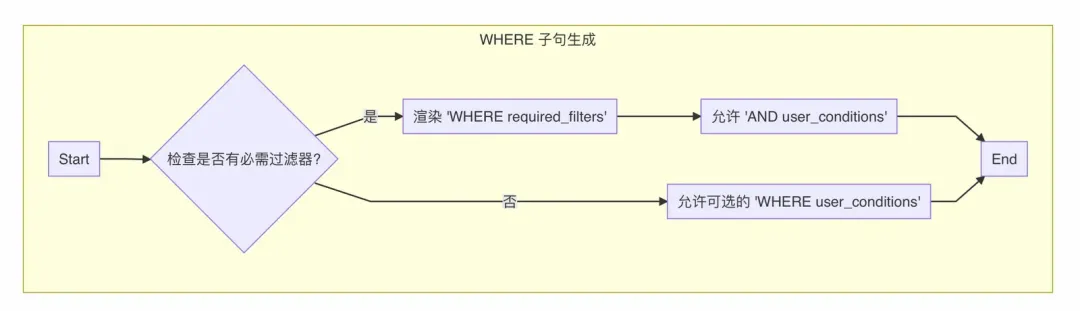

2. 动态 EBNF 生成:灵活性之源

静态的 SQL 语法无法满足我们“可干预”的需求。例如,用户 A 可能只想查询 table1,而可能用户

B 需要查询 table2 并强制带有 WHERE date > '2024-01-01' 的条件。

我们使用 Jinja 模板引擎 来解决这个问题。基础的 SQL EBNF 语法(如 sql_ebnf_simple.jinja

文件所示)被编写为模板,其中包含占位符和条件逻辑。

示例 (简化版):

假设 sql_ebnf_simple.jinja 中有如下片段:

# Table name

{% if tables and tables|length > 0 -%}

table_name ::= {% for table in tables %}{% ifnot

loop.first %} | {% endif %}"{{ table.name

}}"{% endfor %}

{% else -%}

table_name ::= identifier

{% endif %}

# WHERE clause

{% if required_filters and required_filters|length

> 0 -%}

where_clause ::= "WHERE" ws required_conditions

(ws "AND" ws user_conditions)?

required_conditions ::= {% for filter in required_filters

%}{% ifnot loop.first %} ws "AND"

ws {% endif %}{{ filter.column }} {{ filter.operator

}} {{ filter.value }}{% endfor %}

user_conditions ::= expression

{% else -%}

where_clause ::= ("WHERE" ws expression)?

{% endif %}

|

当用户请求传入配置 { "tables": ["dm_ai.table_X"],

"required_filters": [{"column":

"fstatus", "operator": "=",

"value": "1"}] } 时,Jinja 会渲染出如下特定的

EBNF:

#

Table name

table_name ::= "dm_ai.table_X"

# WHERE clause

where_clause ::= "WHERE" ws required_conditions

(ws "AND" ws user_conditions)?

required_conditions ::= fstatus = 1

user_conditions ::= expression

|

这样,生成的 EBNF 就精确地编码了用户的约束,后续的约束解码将强制模型遵守这些规则。

3. EBNF 设计考量:为何强制某些规则?

在 sql_ebnf_simple.jinja 中,我们不仅定义了基础 SQL 语法,还嵌入了一些看似“强制”的规则,这背后是实际业务需求和工程考量:

强制特定过滤条件 (如 fstatus = 1):

业务逻辑: 在我们的场景中,fstatus 列可能代表数据来源或类型(例如,是否为智能饲喂数据)。业务分析通常要求在特定数据子集上进行,或者默认查询“全部”数据(fstatus=1)。如果模型遗漏了这个条件,生成的

SQL 结果可能不完整或与用户预期不符。

EBNF 实现: 通过 Jinja 的条件渲染,我们可以让 WHERE 子句的结构强制包含这些预设条件,同时允许模型在

AND 之后添加其他由用户问题推导出的条件。

图 5: EBNF 中动态处理必需过滤条件的逻辑

强制 LIMIT 子句:

性能与安全: 无 LIMIT 的查询可能意外返回大量数据,对数据库造成压力,甚至导致服务超时或中断。在交互式查询或自动化场景中,强制添加合理的

LIMIT (如 100) 是一个重要的保护措施。

EBNF 实现: Jinja 模板可以配置为总是包含 limit_clause,并且可以根据配置设置默认值或允许模型生成一个整数值。

{# In Jinja Template #}

{% if limit_config and limit_config.enabled

-%}

select_statement_rest_limit ::= ws limit_default_clause

limit_default_clause ::= "LIMIT" ws

"{{ limit_config.value | default('100')

}}" {# Or allow integer #}

{% else -%}

select_statement_rest_limit ::= (ws limit_clause)?

{# Optional LIMIT #}

limit_clause ::= "LIMIT" ws integer

{% endif %} |

约束 GROUP BY 组合:

业务语义: 有时某些维度必须一起分组才有意义(例如,按 forgtype, fdatetype,

fdate 分组)。EBNF 可以定义只允许这些特定组合,防止模型生成无意义或错误的聚合。

通过在 EBNF 层面编码这些规则,我们确保了即使模型本身未能完全理解这些深层约束,其输出也必然符合要求。

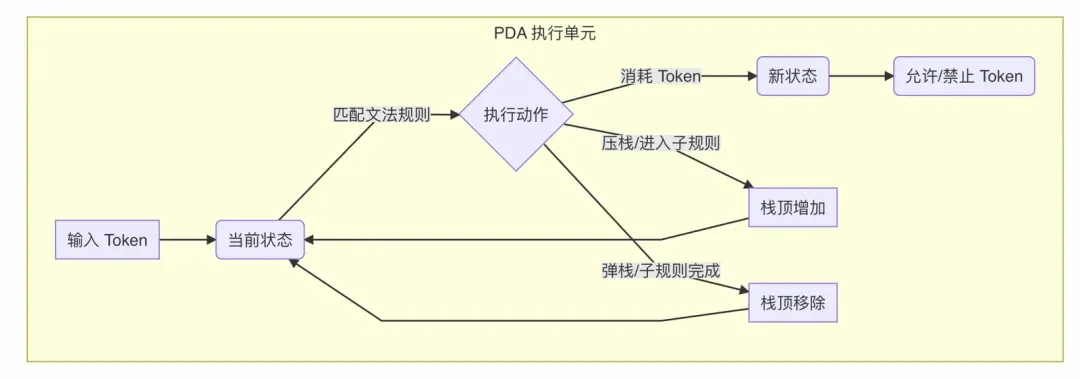

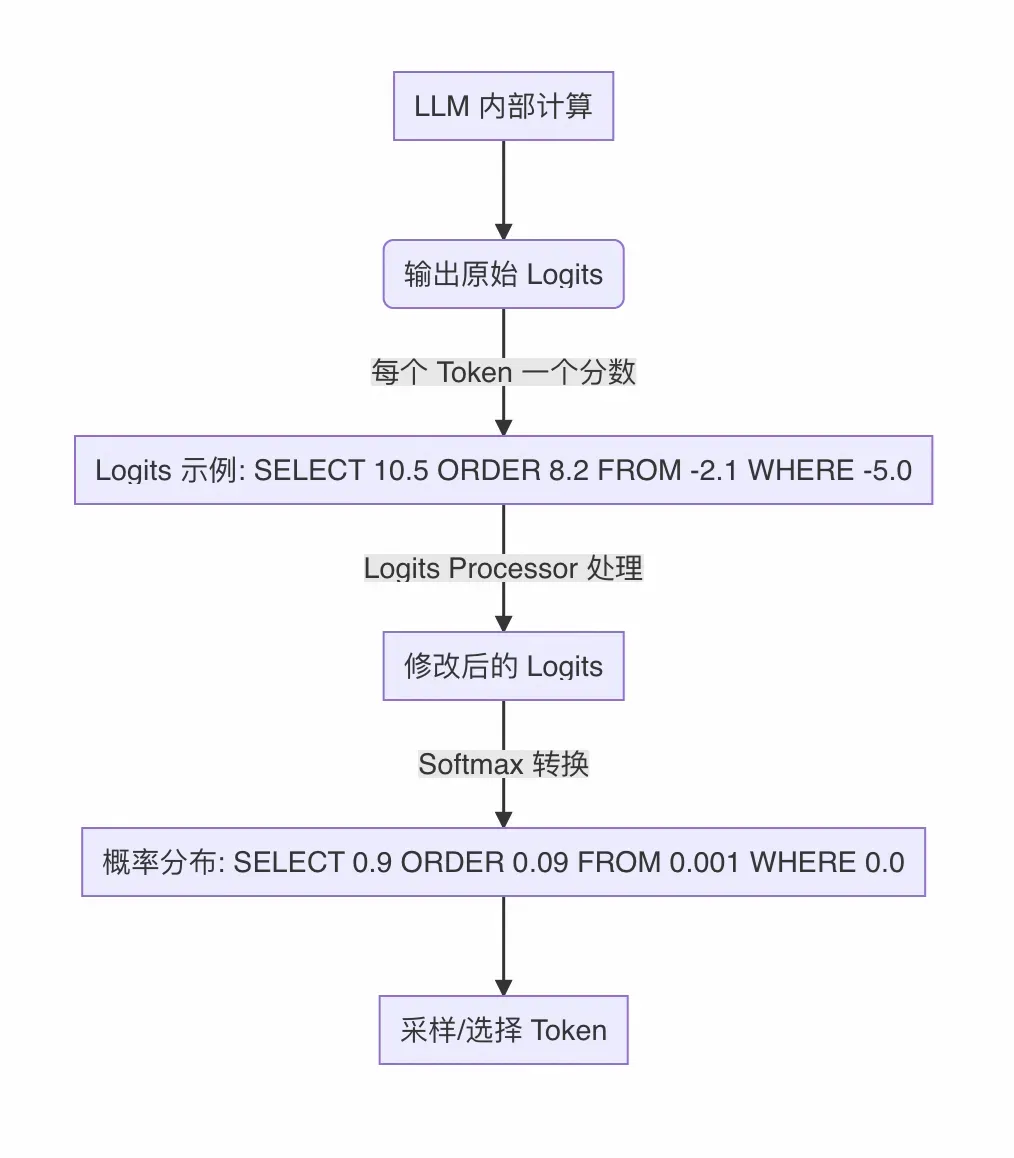

4. 通过 Logits Processor 集成

最后一步是将 XGrammar 的约束能力接入 LLM 的生成流程。Hugging Face transformers

库提供了 LogitsProcessor 接口,它允许我们在模型计算出原始 logits 之后、进行采样或选择之前,对

logits 进行修改。

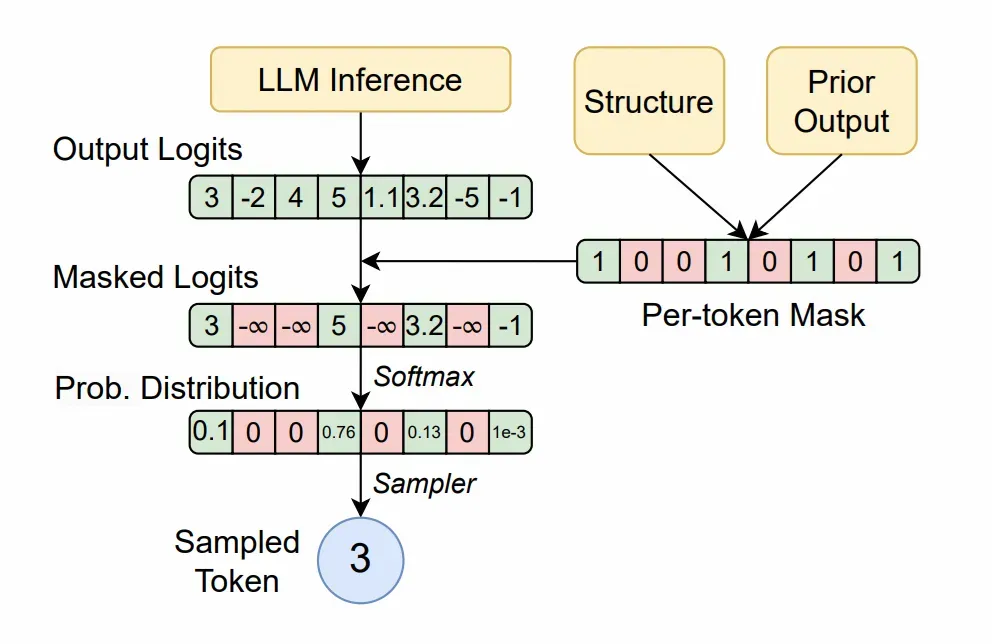

那么,什么是 Logits?

你可以简单地把 Logits 理解为模型对下一个可能的 token 给出的原始‘分数’或‘信心度’。对于词汇表中的每一个

token,模型都会计算一个 logit 值。这个值通常是未经归一化的(不是概率),但分数越高,表示模型认为这个

token 在当前位置出现的可能性越大。

图 6: Logits 的作用与处理流程

我们的 xgr.contrib.hf.LogitsProcessor 实现如下:

1.接收当前已生成的 input_ids 和模型输出的 scores (即原始 logits)。

2.调用 XGrammar 引擎(内部维护着 PDA 的当前状态)。

3.XGrammar 根据当前的 input_ids 和编译好的语法,计算出在当前语法状态下所有合法

token 的掩码 (mask)。

4.将非法 token 的 logits 设置为负无穷 (-inf)。这样,在后续转换为概率时,这些非法

token 的概率会变成 0。

5.返回修改后的 logits。

图 6.1: Logits Processor 工作流程

图 6.2: 整体过程(引用于Xgrammar论文)

这样,模型在下一步选择 token 时,就只能从那些语法和规则都允许的选项中进行选择,从而实现了精确的约束生成。

通过上述方案,我们构建了一个既能保证 SQL 语法正确性,又能灵活适应用户干预需求的生成系统。

Logits Processor 工作流程部分代码实现

# ...

outputs = model(

input_ids=input_ids[:, -1:] if past_key_values

is not None else input_ids,

attention_mask=attention_mask,

past_key_values=past_key_values,

use_cache=True

)

inference_times.append(time.perf_counter() -

infer_start)

# 计时: logits处理

process_start = time.perf_counter()

next_token_logits = outputs.logits[:, -1,

:]

past_key_values = outputs.past_key_values

# 应用语法约束

next_token_logits = xgr_logits_processor(input_ids,

next_token_logits)

probs = torch.softmax(next_token_logits, dim=-1)

next_tokens = torch.multinomial(probs, num_samples=1).squeeze(1)

unfinished_sequences = unfinished_sequences.mul((next_tokens

!= tokenizer.eos_token_id).long())

next_tokens = next_tokens * unfinished_sequences

+ tokenizer.pad_token_id * (1 - unfinished_sequences)

#...

|

5. 结合vllm、sglang实现生产级别可用

理论和实验验证了 Constrained Decoding 的有效性,但要将其推向生产环境,我们需要依赖高性能的

LLM 推理服务框架。vLLM 和 SGLang 就是其中的佼佼者,它们是专门用于高效运行大语言模型的服务框架,提供了很多优化技术,比如

PagedAttention、持续批处理 (Continuous Batching) 等,能让模型跑得更快、同时处理更多请求。

幸运的是,这些主流框架已经内置了对结构化输出(Structured Outputs)的支持,并且可以与我们的动态

EBNF 约束生成方案相结合。

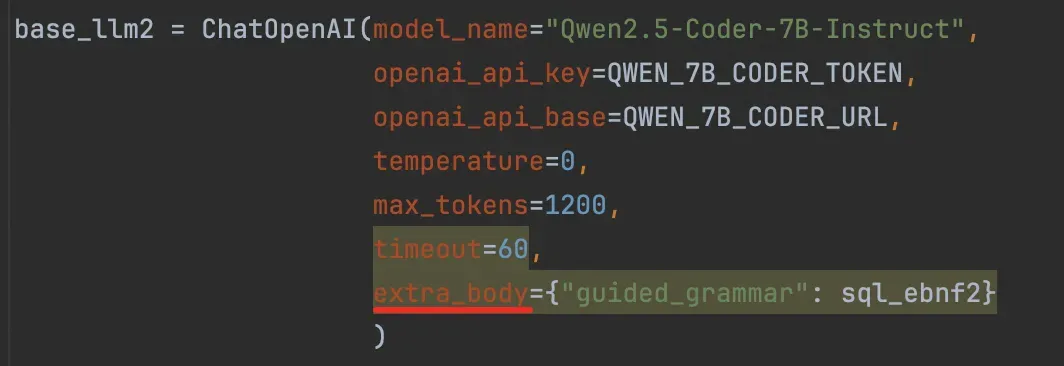

利用现有框架的结构化输出能力:

vLLM: 如其文档[8]所示,vLLM 支持通过 outlines, lm-format-enforcer

或 xgrammar 作为后端来实现引导式解码。它提供了 OpenAI 兼容 API 中的 extra_body

参数(如 guided_grammar, guided_json, guided_regex)以及原生

Python API 中的 GuidedDecodingParams 来指定约束。

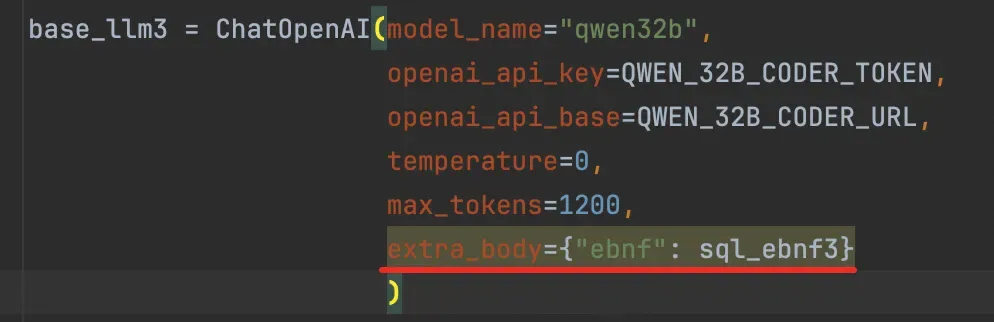

SGLang: SGLang 的文档[9]也明确支持通过 Outlines, XGrammar (默认)

或 llguidance 实现结构化输出。它同样提供了 OpenAI 兼容 API (response_format,

extra_body 中的 ebnf, regex) 和原生 Python API (sampling_params

中的 json_schema, regex, ebnf) 来施加约束。

集成我们的动态 EBNF 方案:

我们的核心方法——使用 Jinja 动态生成 EBNF 字符串——可以无缝集成到 vLLM 和 SGLang

中:

1.生成 EBNF: 在接收到用户请求和自定义规则(JSON 配置)后,调用 generate_dynamic_ebnf

函数生成特定于该请求的 EBNF 语法字符串。

2.传递 EBNF:

对于 vLLM: 将生成的 EBNF 字符串传递给 OpenAI API 的 extra_body={"guided_grammar":

ebnf_string} 或原生 API 的 GuidedDecodingParams(grammar=ebnf_string)。

对于 SGLang: 将 EBNF 字符串传递给 OpenAI API 的 extra_body={"ebnf":

ebnf_string} 或原生 API 的 sampling_params={"ebnf":

ebnf_string}。

解决性能挑战以达生产可用:

正如“挑战与优化”部分所述,性能是关键。要在生产中可用,我们需要充分利用 vLLM 和 SGLang

提供的优化以及约束框架自身的特性:

1.选择高性能后端: 明确指定使用 xgrammar 作为后端(例如,在 vLLM 中使用 guided_decoding_backend="xgrammar",SGLang

默认使用),以利用其针对 CFG 的优化。

2.利用框架优化: vLLM 和 SGLang 本身就包含 PagedAttention、持续批处理

(Continuous Batching) 等先进的推理优化技术,这为高效运行约束解码提供了基础。

3.语法预编译与缓存: 虽然 EBNF 是动态生成的,但对于一些常用的、不包含用户特定信息的语法片段,可以考虑预编译并缓存。更重要的是,确保

XGrammar 或其他后端的编译过程(将 EBNF 转为 PDA 等内部表示)尽可能快,或者利用框架可能提供的缓存机制。

4.流水线与重叠: 依赖 XGrammar 等后端实现的 CPU/GPU 计算重叠能力,将语法检查的

CPU 开销隐藏在 GPU 推理之后。

5.监控与调优: 在生产环境中持续监控约束解码引入的额外延迟,并根据需要调整 EBNF 语法的复杂度、选择更优化的采样策略或进一步优化服务配置。

6.错误处理与回退: vLLM 提供了如 "xgrammar:no-fallback"

选项,用于控制在后端出错时的行为。生产系统需要健壮的错误处理机制。

通过结合 vLLM/SGLang 的高效推理能力和 XGrammar 等优化后的约束解码后端,并辅以动态

EBNF 生成的灵活性,我们有望构建出响应迅速、规则可控且语法精确的生产级 NL2SQL 或其他结构化生成服务。虽然达到“零开销”仍有挑战,但相比于无约束生成或效率低下的早期约束方法,这是一个巨大的进步。

效果展示:约束的力量

理论讲了这么多,这个“内置 SQL 编辑器”在实际中效果如何呢?让我们来看一个具体的例子。

假设我们的任务是回答用户的问题:“华东华南两个区域2023年10月手机销量哪个更高?”

你是一名PostgreSQL专家,现在需要阅读并理解下面的【数据库schema】描述,以及可能用到的【参考信息】,并运用PostgreSQL知识生成sql语句回答【用户问题】。

【用户问题】

华东华南两个区域2023年10月手机销量哪个更高?

你是一名PostgreSQL专家,现在需要阅读并理解下面的【数据库schema】描述,以及可能用到的【参考信息】,并运用PostgreSQL知识生成sql语句回答【用户问题】。

【用户问题】

华东华南两个区域2023年10月手机销量哪个更高?

【数据库schema】

#[Table]: dm_sales.product_sales_daily,

[

CREATE TABLE "dm_sales"."product_sales_daily"

(

fdate DATE, -- 销售日期

fregionname VARCHAR(50), -- 区域名称

fcategoryname VARCHAR(50), -- 商品类别

fsales_amount DECIMAL(15,2), -- 销售金额

fsales_quantity INTEGER, -- 销售数量

fstore_type INTEGER, -- 门店类型: 1-直营店, 2-加盟店,

3-全部

fdata_source INTEGER, -- 数据源: 1-线上, 2-线下,

3-全部

fstatus INTEGER -- 数据状态: 1-有效, 0-无效

)

]

【参考信息】

{

"知识": 查询销售数据时,添加 fdata_source =

3 的过滤条件,代表查询全部渠道数据,缺省时必须添加。,

"知识对应的SQL片段": fdata_source = 3 --

数据源,添加 fdata_source=3 的默认值,代表查询全部渠道

},

{

"知识": 按【区域】查询销售指标(比如:销量、销售额、客单价等),默认添加

fstore_type=3 及 fregionname 作为筛选条件;,

"知识对应的SQL片段": fstore_type = 3 --

使用3代表查询全部门店类型的数据

fregionname = 'xx' -- 使用区域名称筛选,比如提问中是华东区域,则实际筛选的value值为'华东'

},

{

"知识": 查询销量、销售额时,用 fcategoryname

筛选商品类别,包括:手机、电脑、平板、耳机、充电器、数据线、手表、音响、摄像头,

"知识对应的SQL片段": fcategoryname = '手机'

},

{

"知识": 查询指定日期或【每天】或【每日】的销量(比如2023年10月2日),直接输出字段

fsales_quantity,不需要公式计算,

"知识对应的SQL片段": fsales_quantity --

单日销量

},

{

"知识": 在查询销量、销售额等指标时,必须过滤有效数据,添加

fstatus = 1 的条件;,

"知识对应的SQL片段": fstatus = 1 -- 只查询有效数据

},

{

"知识": 查询销量、销售额时,用 fcategoryname

筛选商品类别,包括:手机、电脑、平板、耳机、充电器、数据线、手表、音响、摄像头,

"知识对应的SQL片段": fcategoryname = '手机'

}

【用户问题】

华东华南两个区域2023年10月手机销量哪个更高?```sql

|

同时,我们通过之前的 Jinja 模板和 JSON 配置,给模型设定了以下约束(部分示例):

必须查询 dmsales.productsales_daily 表。

必须包含过滤条件 fdata_source = 3 (代表查询全部渠道数据)。

必须包含过滤条件 fstore_type (门店类型,不带上sql无效)。

必须包含过滤条件 fstatus (数据状态,不带上sql无效)。

以下是用户需要设置的json

{

"tables": [

{

"name": "dm_sales.product_sales_daily",

"required_filters": [

{"column": "fdata_source",

"operator": "=", "value":

"3"},

{"column": "fstore_type"},

{"column": "fstatus"}

]

}

],

"limit_config": {

"enabled": true

}

}

|

我们将相同的用户问题和数据库 Schema 信息输入给配置了 Qwen-Coder-7B 模型的系统,分别在不使用和使用

Constrained Decoding 的情况下生成 SQL。

场景一:无约束解码 (Standard LLM Generation)

当不启用 Constrained Decoding 时,模型生成的 SQL 如下:

SELECT

fregionname,

SUM(fsales_quantity) AS total_sales_quantity

FROM

dm_sales.product_sales_daily

WHERE

fcategoryname = '手机'

AND fdate >= '2023-10-01'

AND fdate < '2023-11-01'

AND fregionname IN ('华东', '华南')

GROUP BY

fregionname

ORDER BY total_sales_quantity DESC

LIMIT 1; |

分析:

优点:模型基本理解了用户的意图,正确地选择了表、关键列 (fregionname, fsales_quantity),识别了时间范围

(2023-10)、商品类别 (手机) 和区域 (华东,华南),并使用了聚合函数 (SUM) 和 GROUP

BY。

缺点:忽略了关键约束,完全没有包含我们在 Prompt 或参考信息中强的fdatasource、fstoretype、fstatus

这些必需的过滤条件。这可能导致查询结果基于错误的数据子集,得到一个有结果,但是错误的结果。

场景二:启用 Constrained Decoding (使用 XGrammar)

当我们启用基于 XGrammar 的 Constrained Decoding,并加载了通过 Jinja

动态生成的 EBNF 语法后,模型生成的 SQL 变为:

SELECT

fregionname,

SUM(fsales_quantity) AS total_sales_quantity

FROM

"dm_sales.product_sales_daily"

WHERE

"fdata_source" = "3"

AND "fstore_type" = 3

AND "fstatus" = 1

AND fdate >= '2023-10-01'

AND fdate < '2023-11-01'

AND fcategoryname = '手机'

AND fregionname IN ('华东', '华南')

GROUP BY

fregionname

ORDER BY

total_sales_quantity DESC

LIMIT 1

; |

分析:

完全符合约束:

所有在 EBNF 中定义的强制性规则都被严格遵守了:表名正确无误,fdatasource = 3、fstoretype

= 3、fstatus = 1 被自动且正确地加入 WHERE 子句。

ORDER BY 和 LIMIT 也按照 EBNF 的规定被添加,使得查询结果直接回答了用户的问题。

语法 100% 正确: 由于生成过程中的每一步都经过了语法的校验,最终的 SQL 在语法层面是绝对可靠的。

模型创造力与约束的结合: 模型仍然负责理解用户问题并生成非强制性的查询部分(如时间范围、商品类别、区域过滤),而

Constrained Decoding 则确保这些部分被嵌入到一个结构正确且符合所有硬性规定的框架中。

经过测试,约束解码的在约束部分的耗时为40ms/token,而推理耗时在18ms/token,测试环境:

思考:约束等于经验

我们可能会问,为什么要费这么大劲去添加各种约束?难道强大的 LLM 不能自己学会这些吗?

现实是,LLM 虽然知识渊博,但在特定领域的“经验”上往往是欠缺的,尤其是在与结构严谨、规则众多的数据库打交道时。它可能知道

SQL 的通用语法,但它不知道:

你们公司的数据表设计有哪些“潜规则”?

哪些过滤条件是出于安全或业务逻辑必须添加的?

哪些列组合在一起才有意义?

如何避免写出性能低下的查询?

这些知识,往往来自于数据库设计者、数据分析师和业务专家的长期实践经验。而 Constrained

Decoding,特别是结合动态 EBNF 生成,恰恰提供了一种将这些宝贵“经验”固化为规则,并注入

LLM 生成过程的有效途径。

这里我把之前dms遇到过的一些具体的客户场景总结部分经典问题,看看它们是如何将“经验”转化为“约束”来解决实际问题的:

1.默认条件

Bad Case: LLM 生成的 SQL 忘记添加全局过滤条件,如 tenant_id = '当前租户ID'

或 is_deleted = 0,导致数据泄露或查询到已删除的无效数据。

经验/约束: 在多租户系统或使用软删除的表中,这些条件是必须的。通过 EBNF 强制在 WHERE

子句中包含这些条件(这个配置会通过 Jinja 模板,在生成的 EBNF 语法的 WHERE 子句规则里,强制加入这些默认条件),相当于告诉模型:“别忘了,我们查数据有基本法!”

2.默认 LIMIT

Bad Case: 用户只是想预览几条数据,但 LLM 生成了没有 LIMIT 的 SQL,可能导致查询返回百万行数据,拖垮数据库。

经验/约束: 交互式查询或探索性分析,默认加上 LIMIT 是一个安全的最佳实践。EBNF 可以确保

LIMIT 子句的存在及其合理值。

3.分组属性约束

Bad Case: 用户想按部门统计人数,LLM 可能只 GROUP BY department_id,但忘记了同时

GROUP BY department_name,导致结果难以解读或在某些 SQL 方言下非法。

经验/约束: 某些属性(如 ID 和 Name)在语义上是绑定的,分组时通常需要一起出现。EBNF

可以定义这些强制的分组组合。

总结来说,这些约束配置并非对 LLM 能力的否定,而是对其能力的有效补充和引导。 它们将人类在特定领域(数据库交互、业务逻辑)积累的经验和最佳实践,转化为机器可以理解和执行的规则。通过

Constrained Decoding,这些规则被无缝集成到生成过程中,使得 LLM 的输出从“看似正确”进化到“实际可用”,大大提高了在严肃场景下的可靠性和成功率。可以说,约束解码的过程,就是将隐性的专家经验显性化、自动化的过程。

挑战与优化

尽管 Constrained Decoding 技术为生成可靠的 SQL 带来了显著优势,但在实践中,我们仍然面临一些挑战,尤其是在平衡约束的严格性、模型的自然生成能力以及系统性能方面。

挑战一:约束对 LLM 生成行为的潜在干扰

Constrained Decoding 的核心是在每个生成步骤中限制 LLM 的选择空间,确保其输出符合预设规则。这就像给正在即兴创作的作家(LLM)递纸条:“下一个词必须是这个或那个”。然而,这种干预有时会像投入湖面的石子,虽然精确地落在了目标点(强制了规则),但其产生的涟漪(对后续生成的影响)可能会超出预期。

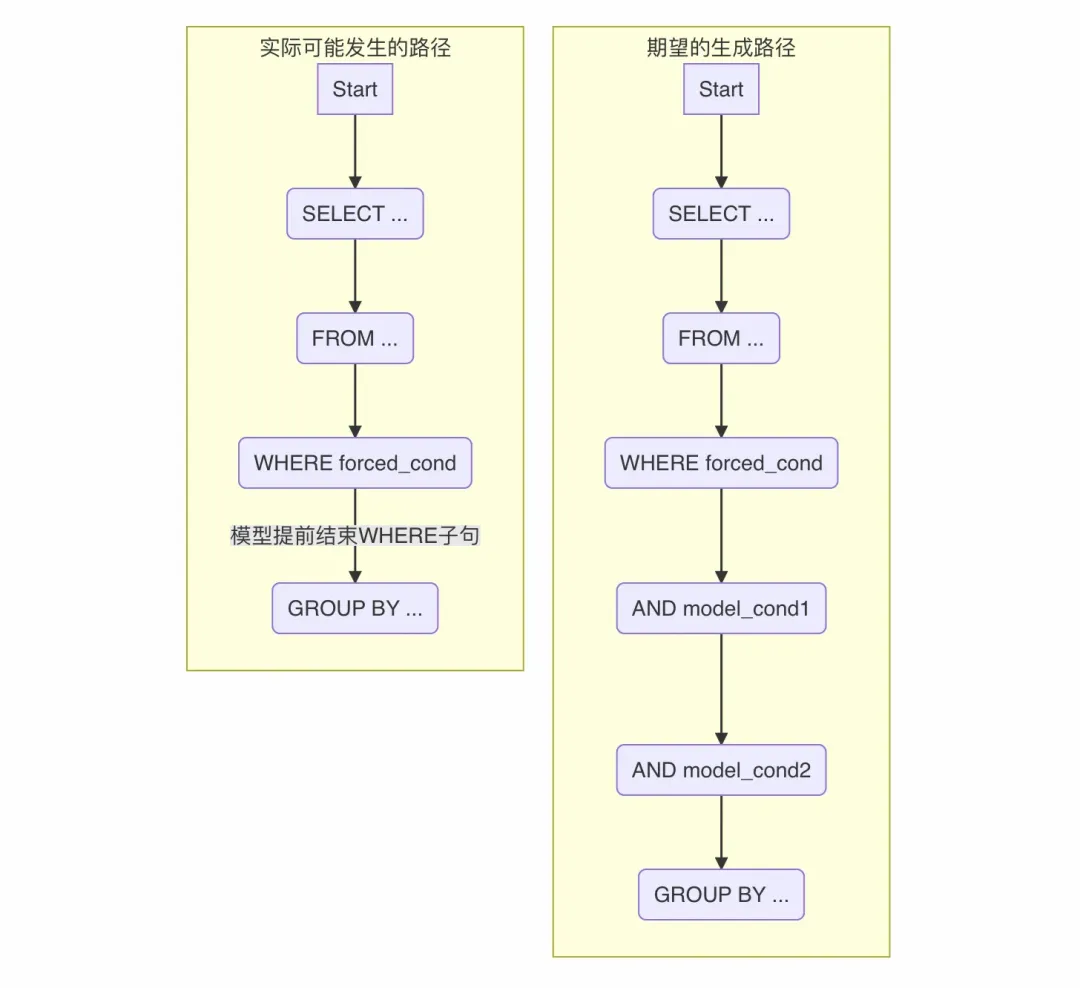

我们观察到,当强制模型生成某个特定结构(比如 WHERE fstatus=1)后,模型有时会“认为”该部分的任务已经完成,不再继续生成其他本应由它根据上下文补充的内容(比如

AND fdate >= '2023-10-01'),而是过早地跳到下一个语法环节(如 GROUP

BY)。

图 7: 约束可能导致模型提前结束子句生成

需要强调的是,这并非 Constrained Decoding 技术本身的错误。 约束解码忠实地执行了它的任务——确保规则被遵守。这种现象更像是

LLM 预测机制对外部干预的一种自然反应。LLM 在训练中学习了生成文本(包括 SQL)的概率模式和典型流程。当我们通过约束强制改变了它在某一步的选择(修改了其预测的

logits 分布),就改变了它后续步骤所看到的“上下文”。模型可能会因此进入一个它在训练数据中较少遇到的状态,导致其后续的预测偏离我们预期的“自然”流程。这有点像“蝴蝶效应”:一个精确的局部干预,可能引发了后续生成路径的意外变化。

解决这个问题需要更综合的策略:可能需要调整 Prompt,更清晰地引导模型在约束条件下继续生成;或者设计更“柔和”的约束,允许模型在强制内容周围有更多灵活性;甚至可能需要对模型进行微调,让它学会更好地在约束环境中“思考”。

挑战二:复杂 CFG 的性能瓶颈 —— 语法的固有复杂度

另一个核心挑战源于性能。其根本原因在于上下文无关文法(CFG)描述复杂语言(如 SQL)时固有的计算复杂度。

虽然 XGrammar 等框架通过精巧的算法(如 PDA 和各种优化)来加速解析,但面对庞大且高度递归的语法规则集,性能开销仍然可能成为瓶颈。

SQL 语法具有以下特点,给高效解析带来挑战:

1.庞大的规则集: 一个完整的 SQL 方言可能包含数百条语法规则和非终结符。

2.深度递归与嵌套: SQL 结构(如表达式、子查询)可以无限嵌套,导致 PDA 需要维护可能非常深的执行栈。

3.歧义性 (Ambiguity): 某些语法结构可能存在多种合法的解析路径,PDA 需要同时管理这些路径(分裂栈),增加了计算和内存开销。

4.巨大的状态空间: 理论上,PDA 的状态(包括栈内容)组合是无限的。虽然实际应用中栈深度有限,但潜在的状态空间仍然非常庞大。

在我们的实验中,即使使用了以性能优化著称的 XGrammar 框架,在处理我们定制的 SQL EBNF

时,也遇到了严重的性能衰减,解码速度一度降至 1.83 秒/token,这对于需要实时响应的应用场景是不可接受的。

导致性能问题的根源有几个方面:

1.CFG 本身的复杂性: SQL 语法包含大量的规则、非终结符和递归结构(例如,表达式可以嵌套表达式)。PDA

在处理这些复杂结构时,需要维护和扩展其状态栈,计算量会随之增加。

2.XGrammar 的已知限制:

左递归 (Left Recursion): 某些 CFG 写法(如 expr ::= expr "+"

term)可能导致 PDA 进入无限循环。虽然可以通过改写语法避免,但这增加了语法设计的复杂性。

非终结符数量: XGrammar 的性能对 CFG 中非终结符(规则名)的数量比较敏感。过多的非终结符可能导致其内部状态空间爆炸式增长,显著降低编译和运行效率(

#127[6]、#203 所述[7])。我们的 SQL EBNF 为了实现灵活性和精确性,引入了较多的非终结符,可能触发了这个问题。这也是后面我们主要优化CFG的方向。

3.Tokenization 与语法的对齐: LLM 的 Tokenizer 可能将一个 SQL

关键字或标识符切分成多个 token,而 CFG 是基于字符或完整词汇进行匹配的。这种不匹配增加了在每个

token 级别进行语法检查的复杂性。

优化探索

面对这些挑战,我们进行了一系列的优化尝试和探索:

1.Jump-Forward Decoding: XGrammar 提供了 jump-forward

API。如果语法在某个状态下确定了接下来必须生成的一长串固定 token(例如,强制的 WHERE

条件 fstatus=1),可以一次性跳过多步解码,减少逐个 token 检查的开销。

2.EBNF 语法优化: 审视和重构 EBNF,减少不必要的非终结符数量,避免左递归,简化规则,可能有助于显著提升

XGrammar 的性能,也是我们目前利用XGrammar主要的优化方向。

3.探索其他解析引擎: 考虑到 Lark (Outlines 使用) 和 XGrammar 各有优劣,我们也在探索使用更成熟的解析器生成器如

ANTLR 作为 LogitsProcessor 的后端,评估其在 SQL 语法上的性能表现,好处是ANTLR天生支持各种sql.g4,都是经过生产校验过的严格语法。不过由于ANTLR不支持增量解析,而大模型在自回归的过程中,每次解析都是仅变化一个token,无法复用中间的解析结果也对性能造成了很大影响。

总的来说,最终目标是构建一个生产可用的、延迟在毫秒级的 CFG 约束 SQL 生成方案。这需要我们在语法设计、框架选择、算法优化和系统集成等多个层面持续努力。

应用场景:赋能数据管理平台

将 LLM 的自然语言理解能力与 Constrained Decoding 的精确控制能力相结合,可以在数据管理和分析领域开辟广泛的应用场景,尤其是在像阿里云数据库管理系统(DMS)这样的综合性平台中。

1.智能化的 NL2SQL (自然语言转 SQL):

面向业务用户: 允许非技术背景的业务人员用自然语言提问(例如,“查询上季度华东区销售额最高的产品”),系统利用

LLM 理解意图,并通过约束解码生成符合公司数据规范、语法正确且包含必要安全过滤(如租户隔离、权限控制)的

SQL,直接在 DMS 中执行并展示结果。这大大降低了数据查询的门槛。

面向开发者/DBA: 辅助专业用户快速生成复杂查询的草稿,特别是当涉及到多表连接、复杂聚合或不熟悉的业务逻辑时。约束解码可以确保生成的

SQL 遵循最佳实践和性能规范。

2.数据治理与安全策略的强制执行:

将数据治理规则(如数据脱敏、特定表的访问控制等)编码到 EBNF 约束中。无论用户如何提问,生成的

SQL 都将自动符合这些安全和合规要求,从源头上防止不合规的数据访问。

通过将这种“内置编辑器”的能力嵌入 DMS,可以显著提升数据查询的易用性、准确性和安全性,使数据管理平台更加智能化和用户友好。

总结与展望

大型语言模型为自动化生成 SQL 提供了强大的潜力,但其固有的“自由度”也带来了语法错误和违反业务规则的风险。通过引入

Constrained Decoding 技术,特别是结合动态 EBNF 语法生成和高效的 CFG

解析框架(如 XGrammar),我们成功地为 LLM 的 SQL 生成过程装上了一个灵活且强大的“编辑器”。

总结来说,该方案的核心优势在于:

保证语法正确性: 从根本上消除了 LLM 生成无效 SQL 的可能性。

强制规则遵守: 允许将数据库设计规范、业务逻辑和安全策略等“专家经验”编码为约束,确保生成结果符合要求。

灵活性与可干预性: 通过 Jinja 模板等方式,可以动态定制约束,适应不同的用户请求和场景。

展望未来,一个关键的优化方向在于降低用户配置和使用约束的门槛。 目前,直接编写或修改 EBNF 语法、配置复杂的

JSON 文件对于非专业用户来说仍然具有挑战性。未来的工作可以探索:

1.可视化配置界面: 开发一个图形化界面,让用户通过点选、拖拽等方式直观地定义约束(例如,选择允许查询的表和列,设置默认过滤条件等),系统自动生成底层的

JSON 配置或 EBNF。

2.基于自然语言的约束配置: 利用 LLM 自身的能力,让用户用自然语言描述他们想要的约束(例如,“查询结果最多显示

50 条”,“所有查询都必须带上当前用户的部门 ID”),然后由另一个 LLM 将这些描述翻译成结构化的

JSON 配置。

3.与元数据管理的深度集成: 自动从数据库的元数据(如 DMS 中已有的表结构、注释、主外键关系)中推断一部分约束,减少用户需要手动配置的内容。

4.预置模板与最佳实践库: 提供针对常见数据库类型(MySQL, PostgreSQL 等)和业务场景(销售分析、用户行为分析等)的约束模板,用户可以在此基础上进行修改。

通过简化配置过程,我们可以让这种强大的约束生成能力惠及更广泛的用户,真正实现将“SQL 编辑器”无缝集成到大模型驱动的数据应用中,使其更加可靠、安全和易用。 |